ToF vs. LiDAR: ¿Cuál es la diferencia?

Últimamente, ha habido tanto ruido en torno a LiDAR en los nuevos dispositivos de Apple que es fácil olvidar que la Realidad Aumentada móvil puede funcionar de cualquier otra forma. Pero puede y lo hace, particularmente con las herramientas ToF que alcanzan nuevas alturas en los teléfonos Samsung.

Ya sea que sea un desarrollador, esté en el mercado de un nuevo dispositivo o simplemente tenga curiosidad, vale la pena tomarse un tiempo para analizar estas siglas y aprender los entresijos de la detección de profundidad de teléfonos móviles.

¿Qué es ToF?

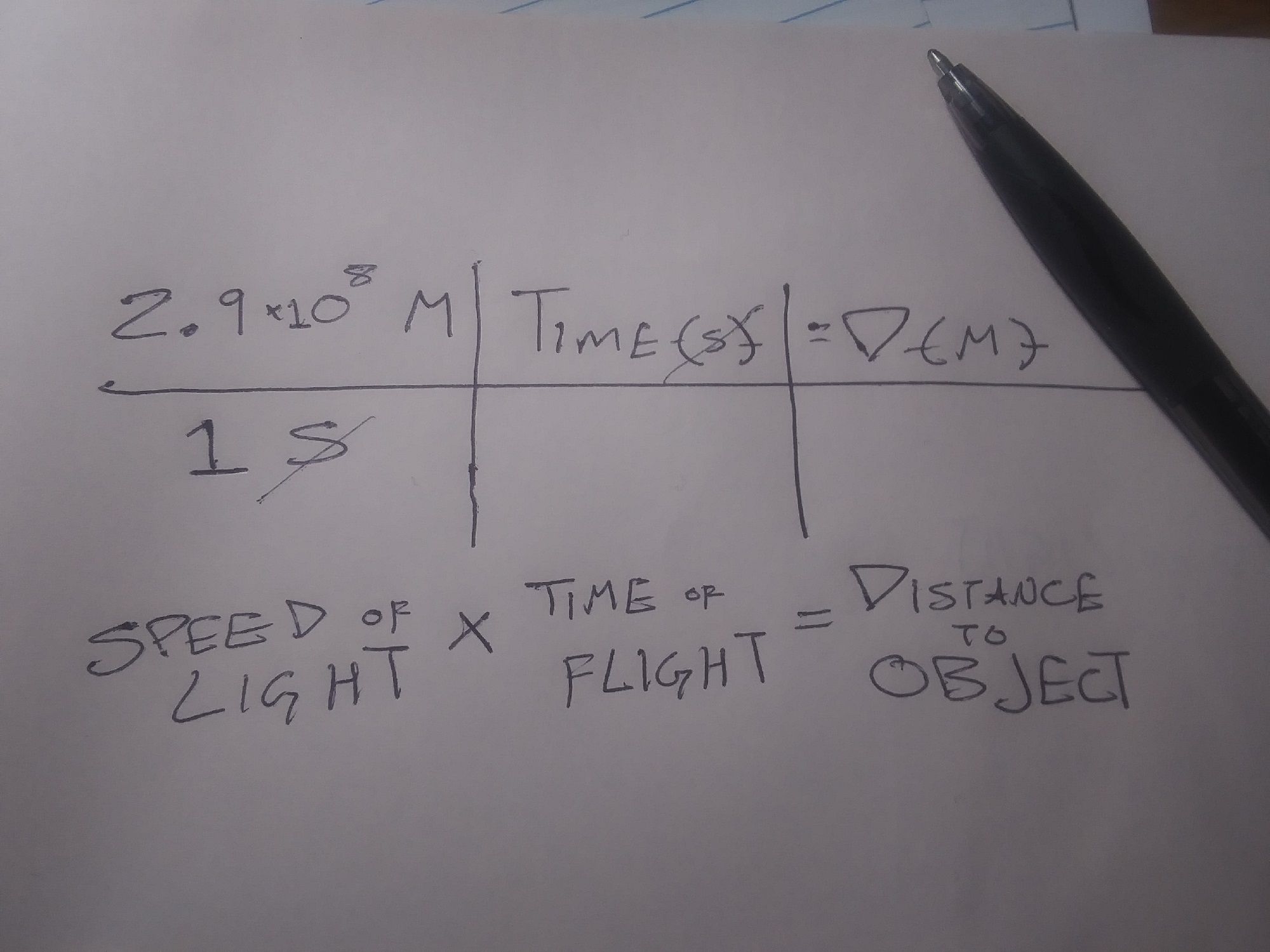

ToF es la abreviatura de Time of Flight.

Técnicamente, ToF se refiere al uso de la velocidad de la luz (o incluso del sonido) para determinar la distancia. Mide el tiempo que tarda la luz (o el sonido) en salir del dispositivo, rebotar en un objeto o avión y regresar al dispositivo, todo dividido por dos revela la distancia entre el dispositivo y el objeto o avión.

Entonces, la relación es que todo LiDAR es un tipo de Time of Fight, pero no todo Time of Flight es LiDAR. Para simplificar las cosas, cuando hablamos de "ToF", nos referimos a la medición de distancia óptica, sin incluir LiDAR.

Entonces, si LiDAR y Optical Non-LiDAR ToF usan luz para la determinación de la distancia y el mapeo 3D, ¿en qué se diferencian?

¿Qué es LiDAR?

LiDAR es la abreviatura de Light Detection and Ranging . Esta tecnología utiliza un láser, o una rejilla de láseres, como fuente de luz en la ecuación detallada anteriormente.

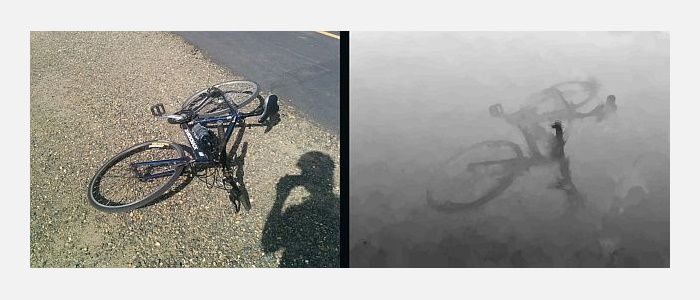

Se puede usar una sola lectura LiDAR para medir cosas como el ancho de una habitación, pero se pueden usar múltiples lecturas LiDAR para crear "nubes de puntos". Estos se pueden utilizar para crear modelos tridimensionales de objetos o mapas topográficos de áreas completas.

Si bien LiDAR puede ser nuevo para los dispositivos móviles, la tecnología en sí ha existido durante bastante tiempo. En entornos no móviles, LiDAR se utiliza para hacer de todo, desde mapear entornos submarinos hasta descubrir sitios arqueológicos.

¿En qué se diferencian LiDAR y ToF?

La diferencia funcional entre LiDAR y otras formas de ToF es que LiDAR usa láseres pulsados para construir una nube de puntos, que luego se usa para construir un mapa o imagen 3D. Las aplicaciones ToF crean "mapas de profundidad" basados en la detección de luz, generalmente a través de una cámara RGB estándar.

La ventaja de ToF sobre LiDAR es que ToF requiere equipos menos especializados para que se pueda utilizar con dispositivos más pequeños y menos costosos. El beneficio de LiDAR proviene de la facilidad con la que una computadora puede leer una nube de puntos en comparación con un mapa de profundidad.

La API de profundidad que Google creó para dispositivos Android funciona mejor en dispositivos habilitados para ToF y funciona creando mapas de profundidad y reconociendo "puntos característicos". Estos puntos característicos, a menudo barreras entre diferentes intensidades de luz, se utilizan para identificar diferentes planos en el entorno. Esto esencialmente crea una nube de puntos de menor resolución.

Cómo funcionan ToF y LiDAR con Mobile AR

Los mapas de profundidad y las nubes de puntos son geniales y, para algunas personas y aplicaciones, son suficientes. Sin embargo, para la mayoría de las aplicaciones de RA, estos datos deben contextualizarse. Tanto ToF como LiDAR hacen esto trabajando junto con otros sensores en el dispositivo móvil. Específicamente, estas plataformas deben comprender la orientación y el movimiento de su teléfono.

Dar sentido a la ubicación del dispositivo dentro de un entorno mapeado se denomina localización y mapeo simultáneo, o "SLaM". SLaM se usa para otras aplicaciones como vehículos autónomos , pero es más necesario que las aplicaciones de AR basadas en dispositivos móviles coloquen objetos digitales en el entorno físico.

Esto es particularmente cierto para las experiencias que permanecen en su lugar cuando el usuario no interactúa con ellas y para colocar objetos digitales que parecen estar detrás de personas y objetos físicos.

Otro factor importante en la colocación de objetos digitales tanto en aplicaciones basadas en LiDAR como en ToF son los "anclajes". Los anclajes son puntos digitales en el mundo físico a los que se "adjuntan" los objetos digitales.

En aplicaciones de escala mundial como Pokemon Go, esto se hace a través de un proceso separado llamado "Geoetiquetado". Sin embargo, en las aplicaciones de AR basadas en dispositivos móviles, el objeto digital está anclado a puntos en una nube de puntos LiDAR o en uno de los puntos característicos de un mapa de profundidad.

¿Es LiDAR mejor que ToF?

Estrictamente hablando, LiDAR es más rápido y más preciso que Time of Flight. Sin embargo, esto se vuelve más significativo con aplicaciones más avanzadas tecnológicamente.

Por ejemplo, ToF y la API de profundidad de Google tienen dificultades para comprender planos grandes de textura baja como paredes blancas. Esto puede dificultar que las aplicaciones que utilizan este método coloquen con precisión objetos digitales en algunas superficies del mundo físico. Las aplicaciones que utilizan LiDAR tienen menos probabilidades de tener este problema.

Sin embargo, es poco probable que las aplicaciones que involucren entornos más grandes o con mayor variedad de texturas tengan este problema. Además, la mayoría de las aplicaciones de RA para consumidores basadas en dispositivos móviles implican el uso de un filtro de RA en la cara o el cuerpo del usuario, una aplicación que es poco probable que tenga problemas debido a las grandes superficies sin textura.

¿Por qué Apple y Google utilizan diferentes sensores de profundidad?

Al lanzar sus dispositivos compatibles con LiDAR, Apple dijo que incluyeron los sensores y otro hardware con el fin de "abrir más flujos de trabajo profesionales y admitir aplicaciones profesionales de fotos y videos". El lanzamiento también llamó a su iPad Pro compatible con LiDAR "el mejor dispositivo del mundo para realidad aumentada" y promocionó las aplicaciones de medición de Apple.

Google no ha dado explicaciones tan directas de por qué su API de profundidad y la nueva línea de dispositivos de soporte no usan LiDAR. Además de trabajar con LiDAR, manteniendo los dispositivos Android más livianos y asequibles, también hay una gran ventaja de accesibilidad.

Dado que Android funciona en dispositivos móviles fabricados por varias empresas, el uso de LiDAR favorecería los modelos compatibles con LiDAR a expensas de todos los demás. Además, debido a que solo requiere una cámara estándar, la API de profundidad es compatible con más dispositivos.

De hecho, la API de profundidad de Google es independiente del dispositivo, lo que significa que los desarrolladores que utilizan la plataforma de creación de experiencia de realidad aumentada de Google pueden desarrollar experiencias que también funcionen en dispositivos Apple.

¿Ha explorado la detección de profundidad?

Este artículo se ha centrado principalmente en LiDAR y ToF en experiencias de RA basadas en dispositivos móviles. Eso se debe en gran parte a que estas experiencias más complejas requieren la mayor explicación. También es porque estas experiencias son las más divertidas y prometedoras.

Sin embargo, enfoques de detección de profundidad como estos son la base de muchas experiencias y herramientas más simples y prácticas que puede usar todos los días sin pensarlo mucho. Con suerte, leer sobre ToF y LiDAR le permitirá apreciar mejor estas aplicaciones.