¿Por qué Apple retrocedió en su función de escaneo de fotos?

En agosto de 2021, Apple reveló sus planes de escanear iPhones en busca de imágenes de abuso sexual infantil. La medida provocó el aplauso de los grupos de protección infantil, pero generó preocupación entre los expertos en privacidad y seguridad de que la función podría ser mal utilizada.

Apple inicialmente planeó incluir la tecnología de escaneo de Material de Abuso Sexual Infantil (CSAM) en iOS 15; en cambio, ha retrasado indefinidamente el lanzamiento de la función para solicitar comentarios antes de su lanzamiento completo.

Entonces, ¿por qué la función de detección de CSAM se convirtió en un tema de acalorado debate y qué hizo que Apple pospusiera su implementación?

¿Qué hace la función de escaneo de fotos de Apple?

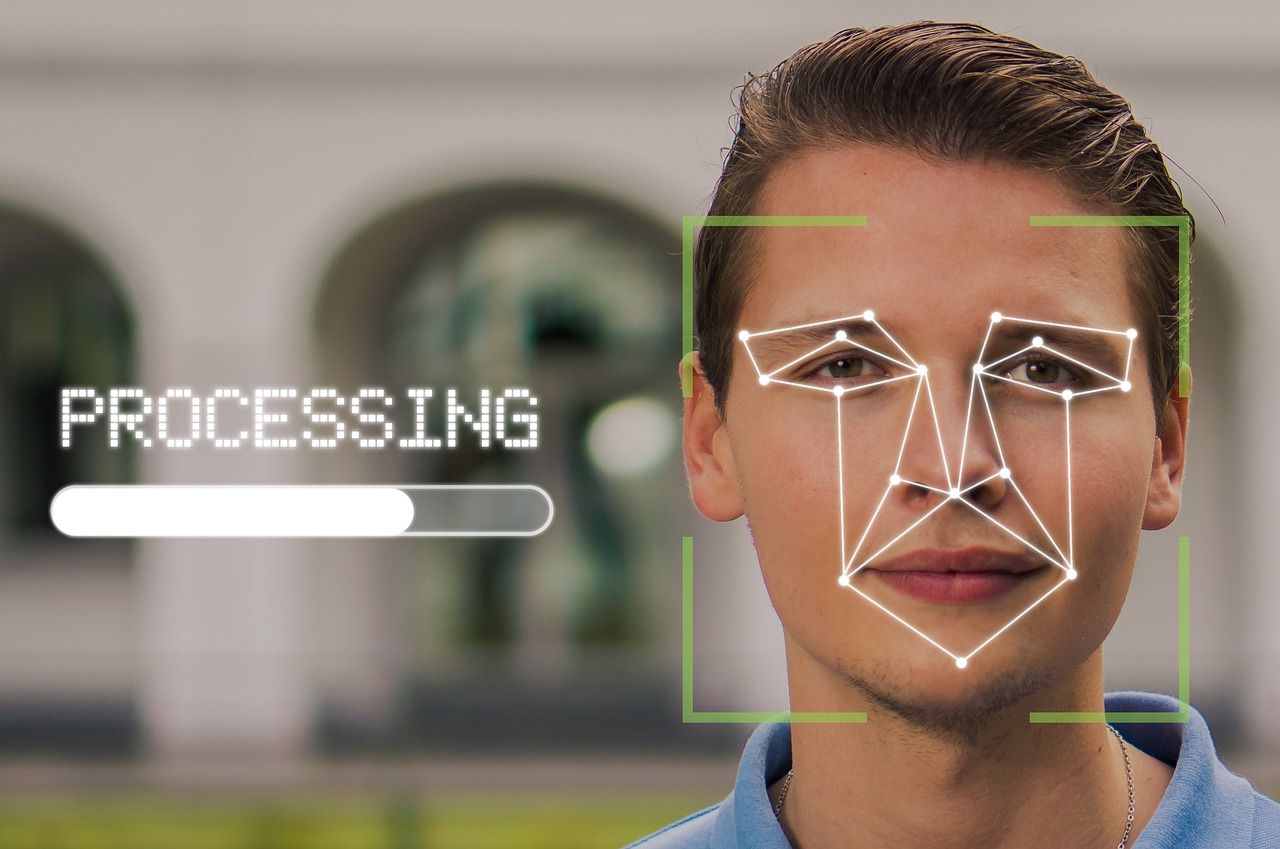

Apple anunció que implementará la función de escaneo de fotografías con la esperanza de combatir el abuso sexual infantil. Todas las fotos en los dispositivos de los usuarios de Apple serán escaneadas en busca de contenido pedofílico usando el algoritmo "NueralHash" creado por Apple.

Además, cualquier dispositivo Apple utilizado por niños tendría una función de seguridad que borrará automáticamente las imágenes de adultos si las recibe un niño, y el usuario recibirá una advertencia dos veces si intenta abrirlos.

Además de minimizar la exposición al contenido para adultos, si los padres registran los dispositivos que pertenecen a sus hijos para mayor seguridad, los padres serán notificados en caso de que el niño reciba contenido explícito de alguien en línea.

En cuanto a los adultos que usan Siri para buscar cualquier cosa que sexualice a los niños, Siri no hará esa búsqueda y sugerirá otras alternativas en su lugar.

Los datos de cualquier dispositivo que contenga 10 o más fotos que los algoritmos consideren sospechosos serán descifrados y sometidos a revisión humana.

Si esas fotos o cualquier otra en el dispositivo coinciden con algo de la base de datos proporcionada por el Centro Nacional para Niños Desaparecidos y Explotados , se informará a las autoridades y se suspenderá la cuenta del usuario.

Principales preocupaciones sobre la función de escaneo de fotografías

La función de detección de CSAM se habría activado con el lanzamiento de iOS 15 en septiembre de 2021, pero ante la protesta generalizada, Apple decidió tomarse más tiempo para recopilar comentarios y realizar mejoras en esta función. Aquí está la declaración completa de Apple sobre el retraso:

"El mes pasado anunciamos planes para funciones destinadas a ayudar a proteger a los niños de los depredadores que usan herramientas de comunicación para reclutarlos y explotarlos, y limitar la propagación de material sobre abuso sexual infantil.

Basándonos en los comentarios de los clientes, grupos de defensa, investigadores y otros, hemos decidido tomarnos más tiempo durante los próximos meses para recopilar información y realizar mejoras antes de lanzar estas características de seguridad infantil de importancia crítica ".

Casi la mitad de las preocupaciones relacionadas con la función de escaneo de fotos de Apple giran en torno a la privacidad; el resto de los argumentos incluyen la probable inexactitud de los algoritmos y el posible uso indebido del sistema o sus lagunas.

Vamos a dividirlo en cuatro partes.

Posible mal uso

Saber que cualquier material que coincida con pornografía infantil o imágenes conocidas de abuso sexual infantil incluirá un dispositivo en la lista de "sospechosos" puede poner en movimiento a los ciberdelincuentes.

Pueden bombardear intencionalmente a una persona con contenido inapropiado a través de iMessage, WhatsApp o cualquier otro medio y hacer que se suspenda la cuenta de esa persona.

Apple ha asegurado que los usuarios pueden presentar una apelación en caso de que sus cuentas hayan sido suspendidas debido a un malentendido.

Abuso de información privilegiada

Aunque está diseñada para una causa benévola, esta función puede convertirse en un desastre total para ciertas personas si sus dispositivos están registrados en el sistema, con o sin su conocimiento, por familiares interesados en monitorear su comunicación.

Incluso si eso no sucede, Apple ha creado una puerta trasera para que los datos de los usuarios sean accesibles al final del día. Ahora es una cuestión de motivación y determinación que las personas accedan a la información personal de otras personas.

No solo facilita una violación importante de la privacidad, sino que también allana el camino para que parientes, tutores, amigos, amantes, cuidadores y ex abusivos, tóxicos o controladores, invadan aún más el espacio personal de alguien o restrinjan su libertad.

Por un lado, está destinado a combatir el abuso sexual infantil; por el otro, se puede utilizar para perpetuar aún más otros tipos de abuso.

Vigilancia gubernamental

Apple siempre se ha promocionado como una marca más consciente de la privacidad que sus competidores. Pero ahora, podría estar entrando en una pendiente resbaladiza de tener que cumplir con las demandas interminables de transparencia en los datos de los usuarios por parte de los gobiernos .

El sistema que ha creado para detectar contenido pedófilo se puede utilizar para detectar cualquier tipo de contenido en los teléfonos. Eso significa que los gobiernos con una mentalidad de culto pueden monitorear a los usuarios a un nivel más personal si lo ponen en sus manos.

Opresiva o no, la participación del gobierno en su vida diaria y personal puede ser desconcertante y es una invasión de su privacidad. La idea de que solo debe preocuparse por tales invasiones si ha hecho algo mal es un pensamiento erróneo y no puede ver la pendiente resbaladiza antes mencionada.

Alarmas falsas

Una de las mayores preocupaciones del uso de algoritmos para hacer coincidir imágenes con la base de datos son las falsas alarmas. Los algoritmos de hash pueden identificar erróneamente dos fotos como coincidencias incluso cuando no son iguales. Estos errores, llamados "colisiones", son especialmente alarmantes en el contexto del contenido de abuso sexual infantil.

Los investigadores encontraron varias colisiones en "NeuralHash" después de que Apple anunciara que usaría el algoritmo para escanear imágenes. Apple respondió las consultas sobre falsas alarmas señalando que el resultado será revisado por un humano al final, por lo que la gente no tiene que preocuparse por eso.

¿La pausa CSAM de Apple es permanente?

Hay muchos pros y contras de la función propuesta por Apple. Cada uno de ellos es genuino y tiene peso. Todavía no está claro qué cambios específicos podría introducir Apple en la función de escaneo CSAM para satisfacer a sus críticos.

Podría limitar el escaneo a álbumes compartidos de iCloud en lugar de involucrar a los dispositivos de los usuarios. Es muy poco probable que Apple abandone estos planes por completo, ya que la empresa no suele estar dispuesta a ceder en sus planes.

Sin embargo, está claro por la reacción generalizada y la suspensión de Apple de sus planes, que las empresas deben incorporar a la comunidad de investigación desde el principio, especialmente para una tecnología no probada.