Nvidia y Microsoft solucionan un gran problema con Copilot+

Cuando Microsoft anunció las PC Copilot+ hace unas semanas, una pregunta reinó : ¿Por qué no puedo ejecutar estas aplicaciones de IA en mi GPU? En Computex 2024 , Nvidia finalmente dio una respuesta.

Nvidia y Microsoft están trabajando juntos en una interfaz de programación de aplicaciones (API) que permitirá a los desarrolladores ejecutar sus aplicaciones aceleradas por IA en tarjetas gráficas RTX. Esto incluye los diversos modelos de lenguaje pequeño (SLM) que forman parte del tiempo de ejecución de Copilot, que se utilizan como base para funciones como recuperación y subtítulos en vivo.

Con el kit de herramientas, los desarrolladores pueden permitir que las aplicaciones se ejecuten localmente en su GPU en lugar de en la NPU. Esto abre la puerta no sólo a aplicaciones de IA más potentes, ya que las capacidades de IA de las GPU son generalmente superiores a las de las NPU, sino también a la capacidad de ejecutarse en PC que actualmente no están bajo el paraguas de Copilot+.

Es un gran movimiento. Las PC Copilot+ actualmente requieren una unidad de procesamiento neuronal (NPU) que sea capaz de realizar al menos 40 tera de operaciones por segundo (TOPS). Por el momento, sólo el Snapdragon X Elite cumple ese criterio. A pesar de eso, las GPU tienen capacidades de procesamiento de IA mucho mayores, incluso los modelos de gama baja alcanzan 100 TOPS y las opciones de gama alta escalan aún más.

Además de ejecutarse en la GPU, la nueva API agrega capacidades de generación aumentada de recuperación (RAG) al tiempo de ejecución de Copilot. RAG le da al modelo de IA acceso a información específica localmente, lo que le permite brindar soluciones más útiles. Vimos RAG en pantalla completa con Chat con RTX de Nvidia a principios de este año.

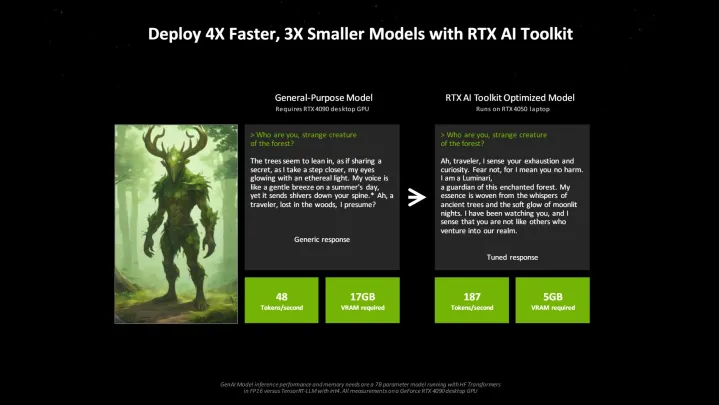

Fuera de la API, Nvidia anunció el RTX AI Toolkit en Computex. Esta suite para desarrolladores, que llegará en junio, combina varias herramientas y SDK que permiten a los desarrolladores ajustar modelos de IA para aplicaciones específicas. Nvidia dice que al utilizar RTX AI Toolkit, los desarrolladores pueden crear modelos cuatro veces más rápidos y tres veces más pequeños en comparación con el uso de soluciones de código abierto.

Estamos viendo una ola de herramientas que permiten a los desarrolladores crear aplicaciones de IA específicas para usuarios finales. Algo de eso ya está apareciendo en las PC Copilot+, pero sospecho que veremos muchas más aplicaciones de IA a estas alturas del próximo año. Después de todo, tenemos el hardware para ejecutar estas aplicaciones; ahora solo necesitamos el software.