Nvidia construyó una GPU dual masiva para impulsar modelos como ChatGPT

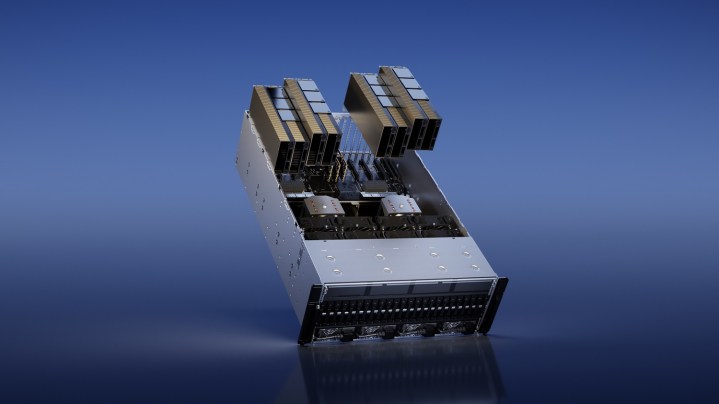

La Conferencia de tecnología de GPU (GTC) semestral de Nvidia generalmente se enfoca en los avances en IA, pero este año, Nvidia está respondiendo al aumento masivo de ChatGPT con una lista de nuevas GPU. El principal de ellos es el H100 NVL, que une dos de las GPU H100 de Nvidia para implementar modelos de lenguaje grande (LLM) como ChatGPT.

La H100 no es una GPU nueva. Nvidia lo anunció hace un año en GTC, luciendo su arquitectura Hopper y prometiendo acelerar la inferencia de IA en una variedad de tareas. Se dice que el nuevo modelo NVL con su enorme memoria de 94 GB funciona mejor cuando se implementan LLM a escala, ofreciendo una inferencia hasta 12 veces más rápida en comparación con el A100 de última generación.

Estas GPU están en el corazón de modelos como ChatGPT. Nvidia y Microsoft revelaron recientemente que se usaron miles de GPU A100 para entrenar ChatGPT , que es un proyecto que lleva más de cinco años en desarrollo.

El H100 NVL funciona mediante la combinación de dos GPU H100 a través de la interconexión NVLink de alto ancho de banda de Nvidia. Esto ya es posible con las GPU H100 actuales; de hecho, puede conectar hasta 256 H100 a través de NVLink, pero esta unidad dedicada está diseñada para implementaciones más pequeñas.

Este es un producto creado para las empresas más que nada, así que no espere ver aparecer el H100 NVL en el estante de su Micro Center local. Sin embargo, Nvidia dice que los clientes empresariales pueden esperar verlo alrededor de la segunda mitad del año.

Además del H100 NVL, Nvidia también anunció la GPU L4, que está diseñada específicamente para impulsar videos generados por IA. Nvidia dice que es 120 veces más potente para videos generados por IA que una CPU y ofrece un 99 % más de eficiencia energética. Además del video generativo de IA, Nvidia dice que la GPU tiene capacidades de decodificación y transcodificación de video y puede aprovecharse para la realidad aumentada.

Nvidia dice que Google Cloud está entre los primeros en integrar el L4. Google planea ofrecer instancias L4 a los clientes a través de su plataforma Vertex AI más tarde hoy. Nvidia dijo que la GPU estará disponible a través de socios más adelante, incluidos Lenovo, Dell, Asus, HP, Gigabyte y HP, entre otros.