Las nuevas GPU refrigeradas por líquido de Nvidia se dirigen a los centros de datos

Nvidia está tomando algunas notas de los entusiastas que construyen PC en un esfuerzo por reducir la huella de carbono de los centros de datos. La compañía anunció dos nuevas GPU refrigeradas por líquido durante su discurso de apertura de Computex 2022 , pero no llegarán a su próxima PC para juegos.

En cambio, las GPU H100 (anunciadas en GTC a principios de este año ) y A100 se enviarán como parte de los racks de servidores HGX hacia finales de año. La refrigeración líquida no es nueva para el mundo de las supercomputadoras, pero los servidores de los centros de datos convencionales tradicionalmente no han podido acceder a este método de refrigeración eficiente (es decir, no sin intentar instalar una GPU de juegos en un servidor).

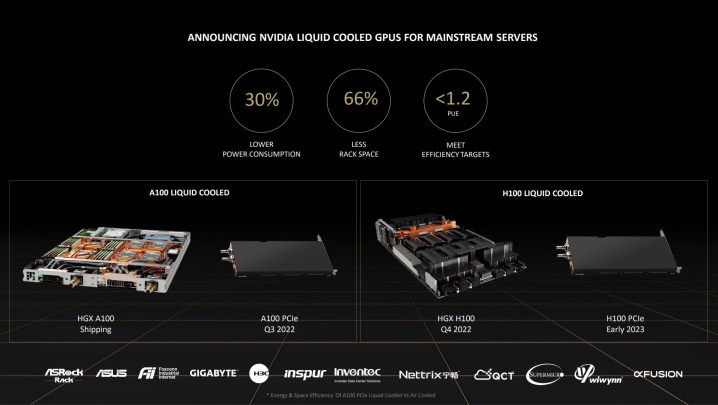

Además de los racks de servidores HGX, Nvidia ofrecerá las versiones refrigeradas por líquido de H100 y A100 como tarjetas PCIe de ranura. El A100 llegará en la segunda mitad de 2022 y el H100 llegará a principios de 2023. Nvidia dice que "al menos una docena" de desarrolladores de sistemas tendrán estas GPU disponibles para fin de año, incluidas las opciones de Asus, ASRock y Gigabyte.

Los centros de datos representan alrededor del 1% del uso total de electricidad en el mundo, y casi la mitad de esa electricidad se gasta únicamente en enfriar todo en el centro de datos. A diferencia de la refrigeración por aire tradicional, Nvidia dice que sus nuevas tarjetas refrigeradas por líquido pueden reducir el consumo de energía en alrededor de un 30 % y reducir el espacio de almacenamiento en un 66 %.

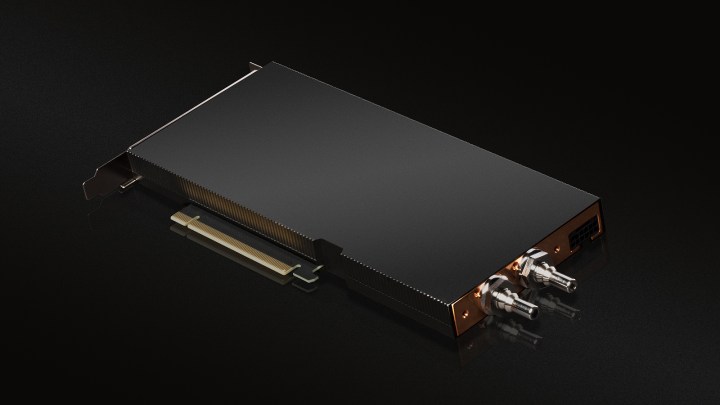

En lugar de un sistema todo en uno como el que encontraría en una GPU para juegos refrigerada por líquido, el A100 y el H100 usan una conexión líquida directa a la unidad de procesamiento. Todo, excepto las líneas de alimentación, está oculto en la carcasa de la GPU, que en sí misma solo ocupa una ranura PCIe (a diferencia de las dos de las versiones refrigeradas por aire).

Los centros de datos analizan la efectividad del uso de energía (PUE) para medir el uso de energía, esencialmente una relación entre la cantidad de energía que consume un centro de datos y la cantidad de energía que usa la informática. Con un centro de datos enfriado por aire, Equinix tenía un PUE de aproximadamente 1,6. La refrigeración líquida con las nuevas GPU de Nvidia lo redujo a 1,15, lo que está notablemente cerca del objetivo de los centros de datos 1,0 PUE.

Además de una mejor eficiencia energética, Nvidia dice que la refrigeración líquida proporciona beneficios para la conservación del agua. La compañía dice que millones de galones de agua se evaporan en los centros de datos cada año para mantener en funcionamiento los sistemas enfriados por aire. El enfriamiento líquido permite que el agua recircule, convirtiendo "un desperdicio en un activo", según el jefe de infraestructura de borde de Equinix Zac Smith.

Aunque estas tarjetas no aparecerán en los centros de datos masivos administrados por Google, Microsoft y Amazon, que probablemente ya usan refrigeración líquida, eso no significa que no tendrán un impacto. Los bancos, las instituciones médicas y los proveedores de centros de datos como Equinix comprometen una gran parte de los centros de datos actuales y todos podrían beneficiarse de las GPU refrigeradas por líquido.

Nvidia dice que esto también es solo el comienzo de un viaje hacia centros de datos neutrales en carbono. En un comunicado de prensa, el gerente senior de marketing de productos de Nvidia, Joe Delaere, escribió que la compañía planea "apoyar la refrigeración líquida en nuestras GPU de centro de datos de alto rendimiento y nuestras plataformas Nvidia HGX en el futuro previsible".