Las caras generadas por IA se están apoderando de Internet

The Times hizo un perfil de una mujer ucraniana de 18 años llamada “Luba Dovzhenko” en marzo para ilustrar la vida bajo asedio. Ella, afirmaba el artículo, estudió periodismo, hablaba “mal inglés” y comenzó a portar un arma después de la invasión rusa.

Sin embargo, el problema era que Dovhenko no existe en la vida real, y la historia fue eliminada poco después de su publicación.

Luba Dovhenko era una persona falsa en línea diseñada para capitalizar el creciente interés en las historias de guerra entre Ucrania y Rusia en Twitter y ganar muchos seguidores. La cuenta no solo nunca tuiteó antes de marzo, sino que también tenía un nombre de usuario diferente, y las actualizaciones que había estado tuiteando, que es lo que posiblemente llamó la atención de The Times, habían sido extraídas de otros perfiles genuinos. La evidencia más condenatoria de su fraude, sin embargo, estaba justo en su rostro.

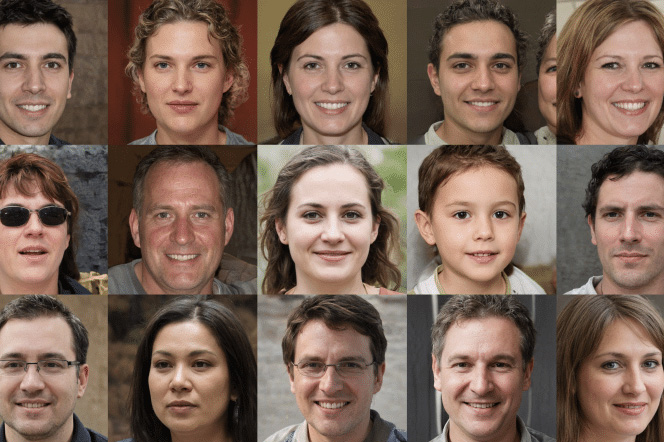

En la foto de perfil de Dovhenko, algunos mechones de su cabello estaban separados del resto de su cabeza, le faltaban algunas pestañas y, lo que es más importante, sus ojos estaban sorprendentemente centrados. Todos eran signos reveladores de una cara artificial tosida por un algoritmo de IA.

El posicionamiento de las características faciales no es la única anomalía en la foto de perfil de @lubadovzhenko1 ; no el cabello desprendido en la parte inferior derecha de la imagen y las pestañas parcialmente faltantes (entre otras cosas). pic.twitter.com/UPuvAQh4LZ

– Conspirador Norteño (@conspirator0) 31 de marzo de 2022

El rostro de Dovhenko fue fabricado por la tecnología detrás de los deepfakes , una técnica cada vez más popular que permite a cualquier persona superponer un rostro sobre el de otra persona en un video y se emplea para todo, desde venganza pornográfica hasta manipular los discursos de los líderes mundiales. Y al alimentar dichos algoritmos con millones de imágenes de personas reales, se pueden reutilizar para crear rostros realistas como el de Dovhenko de la nada. Es un problema creciente que dificulta aún más la lucha contra la desinformación.

Un ejército de caras falsas generadas por IA

En los últimos años, a medida que las redes sociales toman medidas enérgicas contra los trolls anónimos y sin rostro, la IA ha armado a los actores y bots maliciosos con un arma invaluable: la capacidad de parecer alarmantemente auténticos. A diferencia de antes, cuando los trolls simplemente arrancaban rostros reales de Internet y cualquiera podía desenmascararlos invirtiendo la imagen de su foto de perfil, es prácticamente imposible que alguien haga lo mismo con las fotos generadas por IA porque son frescas y únicas. E incluso después de una inspección más cercana, la mayoría de las personas no pueden notar la diferencia.

La Dra. Sophie Nightingale, profesora de psicología en la Universidad de Lancaster del Reino Unido, descubrió que las personas tienen solo un 50 % de posibilidades de detectar un rostro sintetizado por IA, y muchos incluso los consideraron más confiables que los reales. Los medios para que cualquier persona acceda al "contenido sintético sin un conocimiento especializado de Photoshop o CGI", dijo a Digital Trends, "crea una amenaza significativamente mayor para usos nefastos que las tecnologías anteriores".

Lo que hace que estos rostros sean tan evasivos y altamente realistas, dice Yassine Mekdad, investigadora de seguridad cibernética de la Universidad de Florida, cuyo modelo para detectar imágenes generadas por IA tiene una precisión del 95,2 %, es que su programación (conocida como Red Adversaria Generativa) utiliza dos redes neuronales opuestas que trabajan una contra la otra para mejorar una imagen. Uno (G, generador) tiene la tarea de generar las imágenes falsas y engañar al otro, mientras que el segundo (D, discriminador) aprende a diferenciar los resultados del primero de los rostros reales. Este "juego de suma cero" entre los dos permite que el generador produzca "imágenes indistinguibles".

Y las caras generadas por IA se han apoderado de Internet a un ritmo vertiginoso. Además de cuentas como la de Dovhenko que utilizan personas sintetizadas para acumular seguidores, últimamente esta tecnología ha impulsado campañas mucho más alarmantes.

Cuando Google despidió a un investigador de ética de IA, Timnit Gebru, en 2020 por publicar un artículo que destacaba sesgos en los algoritmos de la empresa, surgió una red de bots con rostros generados por IA , que afirmaban que solían trabajar en la división de investigación de IA de Google. redes sociales y tendieron una emboscada a cualquiera que hablara a favor de Gebru. Se han detectado actividades similares de países como China que promueven narrativas gubernamentales.

En una revisión superficial de Twitter, no me tomó mucho tiempo encontrar varios anti-vacunas , pro-rusos y más, todos escondidos detrás de una cara generada por computadora para impulsar sus agendas y atacar a cualquiera que se interpusiera en su camino. Aunque Twitter y Facebook eliminan con regularidad este tipo de botnets, no cuentan con un marco para abordar a los trolls individuales con una cara sintética, a pesar de que la política de identidades engañosas y engañosas del primero “prohíbe la suplantación de personas, grupos u organizaciones para engañar, confundir o engañar a otros, ni usar una identidad falsa de una manera que interrumpa la experiencia de los demás”. Es por eso que cuando informé de los perfiles que encontré, me informaron que no violaban ninguna política.

Sensity, una empresa de soluciones de fraude basada en IA, estima que entre el 0,2 % y el 0,7 % de las personas en las redes sociales populares usan fotos generadas por computadora. Eso no parece mucho por sí solo, pero para Facebook (2900 millones de usuarios), Instagram (1400 millones de usuarios) y Twitter (300 millones de usuarios), significa millones de bots y actores que potencialmente podrían ser parte de campañas de desinformación. .

El porcentaje de coincidencia de una extensión Chrome de detector de rostros generada por IA de V7 Labs corroboró las cifras de Sensity. Su director ejecutivo, Alberto Rizzoli, afirma que, en promedio, el 1% de las fotos que la gente sube se marcan como falsas.

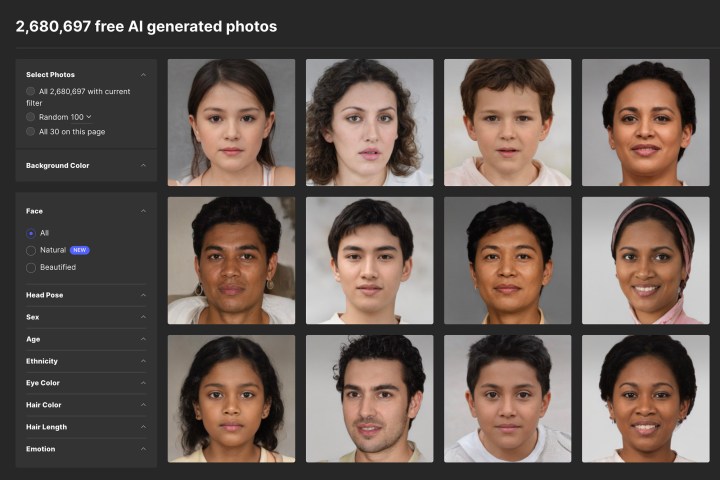

El mercado de las caras falsas

Parte de por qué las fotos generadas por IA han proliferado tan rápidamente es lo fácil que es obtenerlas. En plataformas como Generated Photos , cualquiera puede adquirir cientos de miles de rostros falsos de alta resolución por un par de dólares, y las personas que necesitan algunos para fines únicos, como campañas personales de difamación, pueden descargarlos de sitios web como thispersondoesnotexist .com , que genera automáticamente una nueva cara sintética cada vez que lo recargas.

Estos sitios web han hecho que la vida sea especialmente desafiante para personas como Benjamin Strick, director de investigaciones del Centro para la Resiliencia de la Información del Reino Unido, cuyo equipo pasa horas todos los días rastreando y analizando contenido engañoso en línea.

“Si incluyes [tecnologías autogenerativas] en un paquete de perfiles falsos, trabajando en una startup falsa (a través de thisstartupdoesnotexist.com)”, dijo Strick a Digital Trends, “hay una receta para la ingeniería social y una base para estrategias muy engañosas”. prácticas que se pueden configurar en cuestión de minutos”.

Sin embargo, Ivan Braun, el fundador de Generated Photos, argumenta que no todo es malo. Sostiene que las fotos GAN tienen muchos casos de uso positivos, como anonimizar caras en la vista de la calle de Google Maps y simular mundos virtuales en los juegos, y eso es lo que promueve la plataforma. Si alguien está en el negocio de engañar a la gente, Braun dice que espera que las defensas antifraude de su plataforma puedan detectar las actividades dañinas y que eventualmente las redes sociales puedan filtrar las fotos generadas de las auténticas.

Pero regular la tecnología generativa basada en IA también es complicado, ya que también impulsa innumerables servicios valiosos, incluido el último filtro en Snapchat y las funciones de iluminación inteligente de Zoom. El CEO de Sensity, Giorgio Patrini, está de acuerdo en que prohibir servicios como Generated Photos no es práctico para detener el aumento de rostros generados por IA. En cambio, existe una necesidad urgente de enfoques más proactivos de las plataformas.

Hasta que eso suceda, la adopción de medios sintéticos seguirá erosionando la confianza en las instituciones públicas como los gobiernos y el periodismo, dice Tyler Williams, director de investigaciones de Graphika, una firma de análisis de redes sociales que ha descubierto algunas de las campañas más extensas que involucran personas falsas. . Y un elemento crucial en la lucha contra el uso indebido de tales tecnologías, agrega Williams, es "un plan de estudios de alfabetización mediática que comience desde una edad temprana y capacitación en verificación de fuentes".

¿Cómo detectar una cara generada por IA?

Por suerte para ti, hay algunas formas infalibles de saber si una cara se creó artificialmente. Lo que hay que recordar aquí es que estas caras se evocan simplemente mezclando toneladas de fotos. Entonces, aunque la cara real se verá real, encontrará muchas pistas en los bordes: las formas de las orejas o los aretes pueden no coincidir, los mechones de cabello pueden estar volando por todos lados y el borde de los anteojos puede ser extraño: la lista sucede. El obsequio más común es que cuando recorre algunas caras falsas, todos sus ojos estarán exactamente en la misma posición: en el centro de la pantalla. Y puede probar con el truco del " boleto de tren doblado ", como lo demuestra aquí Strick.

Nightingale cree que la amenaza más importante que representan las fotos generadas por IA es alimentar el "dividendo del mentiroso": la mera existencia de ellas permite que cualquier medio sea descartado como falso. “Si no podemos razonar sobre los hechos básicos del mundo que nos rodea”, argumenta, “entonces esto pone a nuestras sociedades y democracias en riesgo sustancial”.