La popularidad de ChatGPT puede dar a Nvidia un impulso inesperado

El zumbido constante en torno a ChatGPT de OpenAI se niega a disminuir. Ahora que Microsoft usa la misma tecnología para potenciar su nuevo Bing Chat , es seguro decir que ChatGPT puede continuar con esta tendencia ascendente durante bastante tiempo. Esas son buenas noticias para OpenAI y Microsoft, pero no son las dos únicas empresas que se benefician.

Según un nuevo informe, las ventas de tarjetas gráficas para centros de datos de Nvidia pueden estar a punto de dispararse. Con la comercialización de ChatGPT, OpenAI podría necesitar hasta 10 000 GPU nuevas para respaldar el modelo en crecimiento, y Nvidia parece ser el proveedor más probable.

La firma de investigación TrendForce compartió algunas estimaciones interesantes hoy, y la parte más interesante se refiere al futuro de ChatGPT. Según TrendForce, el modelo GPT que impulsa a ChatGPT pronto necesitará un aumento considerable en el hardware para escalar el desarrollo.

“La cantidad de parámetros de entrenamiento utilizados en el desarrollo de este modelo de lenguaje autorregresivo aumentó de alrededor de 120 millones en 2018 a casi 180 mil millones en 2020”, dijo TrendForce en su informe. Aunque no compartió ninguna estimación para 2023, es seguro asumir que estos números solo seguirán aumentando tanto como lo permitan la tecnología y el presupuesto.

La firma afirma que el modelo GPT necesitaba la friolera de 20 000 tarjetas gráficas para procesar datos de entrenamiento en 2020. A medida que continúa expandiéndose, se espera que ese número supere las 30 000. Esta podría ser una gran noticia para Nvidia.

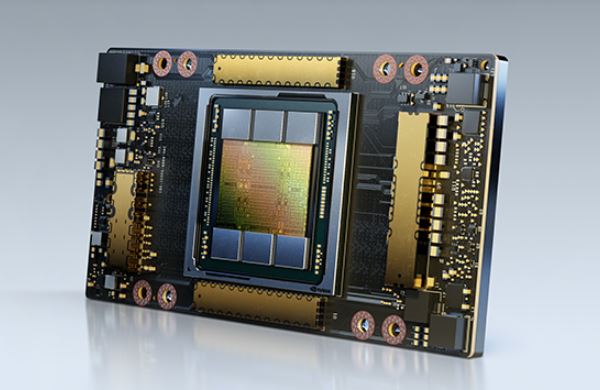

Estos cálculos se basan en la suposición de que OpenAI usaría las GPU A100 de Nvidia para potenciar el modelo de lenguaje. Estas tarjetas gráficas ultrapotentes son realmente costosas, en el rango de $ 10,000 a $ 15,000 cada una. Tampoco son las mejores tarjetas de centro de datos de Nvidia en este momento, por lo que es posible que OpenAI opte por las tarjetas H100 más nuevas, que se supone que ofrecen hasta tres veces el rendimiento de A100. Estas GPU vienen con un gran aumento de precio, con una tarjeta que cuesta alrededor de $ 30,000 o más.

El mercado de GPU para centros de datos no solo consiste en Nvidia: Intel y AMD también venden aceleradores de IA. Sin embargo, Nvidia a menudo se ve como la solución de referencia para tareas relacionadas con la IA , por lo que es posible que pueda obtener un trato lucrativo si OpenAI decide expandirse.

¿Deberían los jugadores preocuparse si Nvidia, de hecho, termina suministrando la friolera de 10,000 GPU para encender ChatGPT? Eso depende. Las tarjetas gráficas requeridas por OpenAI no tienen nada que ver con las mejores GPU para jugadores de Nvidia, por lo que estamos a salvo allí. Sin embargo, si Nvidia termina cambiando parte de la producción a las GPU del centro de datos, podríamos ver un suministro limitado de tarjetas gráficas de consumo en el futuro. Siendo realistas, el impacto puede no ser tan malo, incluso si la predicción de 10,000 GPU se cumple, Nvidia no necesitará entregarlos todos de inmediato.