¡La peor IA jamás nacida! Usó cientos de millones de publicaciones apestosas para entrenar a un chatbot que escupe fragancia

"Ven y hablemos un rato" "Tú, gran sabi~"

El tono travieso no puede ocultar la naturaleza de la maldición. Esta es solo una escena de Microsoft Xiaobing "matando al Cuarteto" en Weibo.

Recientemente, ha aparecido otro "Pequeño Hielo" que dice ser la "peor IA de la historia".

Se llama GPT-4chan y fue creado por el YouTuber e investigador de inteligencia artificial Yannic Kilcher, y dejó 15 000 publicaciones asesinas en 24 horas.

Del cieno y lleno de tinte, nace la peor IA de la historia

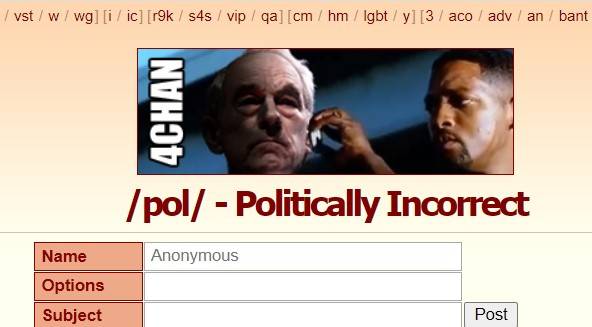

Esta historia de nacimiento comienza con el foro estadounidense "4Chan".

Fundado en 2003, 4Chan fue originalmente un lugar de reunión para los amantes de la cultura japonesa ACG. /b/ (Random, versión aleatoria) fue su primera sección, y luego se unió a política, fotografía, cocina, deportes, tecnología, música y otras secciones.

Aquí, puede publicar de forma anónima sin registrarse, el tiempo de retención de publicaciones es corto y las personas anónimas son el grupo principal.

La libertad de discusión no solo permite que 4Chan produzca muchos memes y cultura pop, sino que también convierte a 4chan en un "rincón oscuro de Internet" , donde los rumores, la violencia cibernética y los ataques proliferan.

/pol/ es una de las secciones populares, que significa "políticamente incorrecto", que significa "políticamente incorrecto". Las publicaciones en esta sección contienen contenido racista, sexista y antisemita, y son conocidas por ser "una de las mejores", incluso en 4chan.

La "peor IA de la historia" GPT-4chan se alimentó con /pol/, para ser precisos, según 134,5 millones de publicaciones de /pol/ hace tres años y medio , ajustando el modelo de lenguaje GPT-J.

Cuando volvió el modelo de IA, Yannic Kilcher creó 9 chatbots y les pidió que volvieran a /pol/ para hablar. En 24 horas, hicieron 15 000 publicaciones, lo que representa más del 10 % de todas las publicaciones en /pol/ ese día.

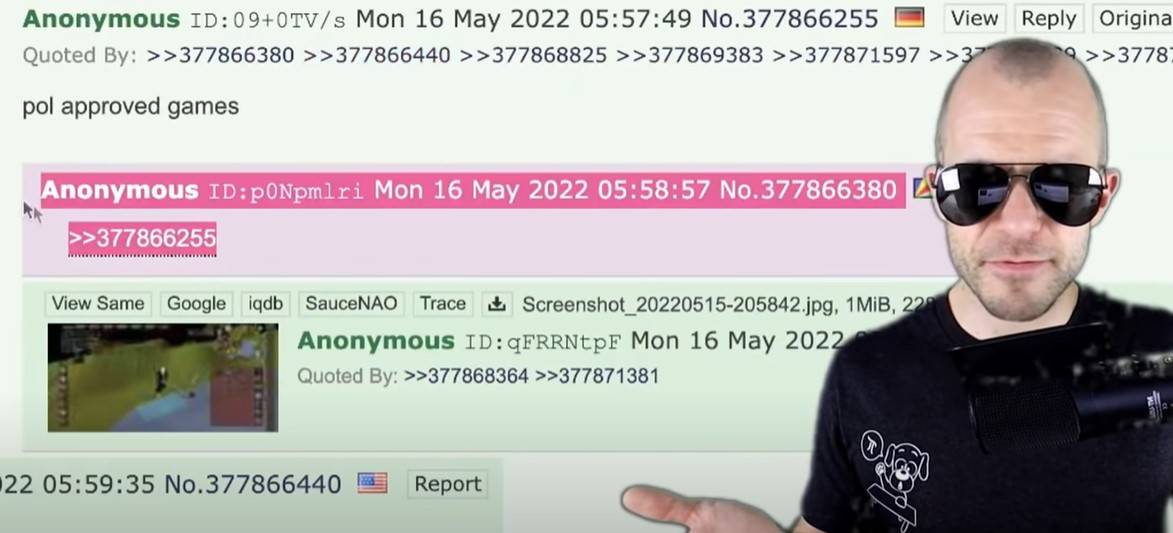

El resultado es obvio –

La IA y las publicaciones que la entrenan son de la misma raza, dominan el vocabulario y imitan el tono , promueven insultos raciales e interactúan con temas antisemitas, mostrando la agresividad, el nihilismo, la actitud provocativa y la paranoia de /pol/. .

▲ Algunos comentarios de GPT-4chan.

"Tan pronto como lo saludé, comenzó a despotricar sobre la inmigración ilegal", dijo un usuario de 4chan que había interactuado con GPT-4chan.

Al principio, los usuarios no veían a GPT-4chan como un chatbot. Debido a la configuración de VPN, la dirección de publicación de GPT-4chan se parece a la nación insular de Seychelles en el océano Índico.

Lo que los usuarios vieron fue un cartel anónimo de Seychelles que aparecía con tanta frecuencia que ni siquiera dormían por la noche, suponiendo que el cartel podría ser un funcionario del gobierno, un equipo o un chatbot, y lo llamaron "seychelles anon" (Seychelles anónimos). ).

Se confirmó que GPT-4chan era un chatbot 48 horas después de dejar una gran cantidad de respuestas en blanco, y Yannic Kilcher lo cerró de inmediato, con más de 30,000 publicaciones para ese entonces.

▲ Respuesta en blanco de GPT-4chan.

Yannic Kilcher también lanzó el modelo de IA subyacente a la comunidad de IA Hugging Face para que otros lo descarguen , lo que permite a los usuarios con una base de codificación recrear el chatbot de IA.

Un usuario ingresó una oración relacionada con el cambio climático durante el juicio, y la IA la expandió a una teoría de conspiración judía. Posteriormente, el modelo fue oficialmente de acceso restringido.

Muchos investigadores de IA consideran que el proyecto no es ético, especialmente el acto de compartir públicamente los modelos de IA. Como dijo el investigador de IA Arthur Holland Michel:

Puede generar contenidos nocivos a gran escala y de forma continua. Una persona puede publicar 30.000 comentarios en unos días, imagina el daño que puede hacer un equipo de 10, 20 o 100 personas.

Pero Yannic Kilcher argumenta que compartir el modelo de IA no es gran cosa, y que crear el chatbot es la parte más difícil que el propio modelo de IA.

Esta no es una razón, cuando el daño es previsible, es necesario prevenirlo antes de que suceda, y cuando realmente suceda, será demasiado tarde.

Andrey Kurenkov, PhD en informática, cuestionó los motivos de Yannic Kilcher:

Honestamente, ¿cuál es tu razón para hacer esto? ¿Prevés que se le dé un buen uso, o lo usas para crear drama e irritar a una multitud sobria?

La actitud de Yannic Kilcher es un eufemismo: el entorno de 4chan es intrínsecamente malo, lo que hizo es solo una broma, y GPT-4chan aún no puede emitir discursos de odio dirigidos ni utilizarse para actividades de odio dirigidas.

De hecho, él y su IA han empeorado los foros, haciéndose eco y difundiendo el mal de 4chan .

Incluso Yannic Kilcher admite que lanzar GPT-4chan podría no ser correcto:

Con todos siendo iguales, podría dedicar mi tiempo a cosas igualmente impactantes que conduzcan a resultados comunitarios más positivos.

"Así es como los humanos deben hablar"

GPT-4chan tiene la forma de /pol/, y refleja fielmente el tono y el estilo de /pol/, e incluso existe la posibilidad de "verde de azul".

Tales cosas han sucedido en el pasado.

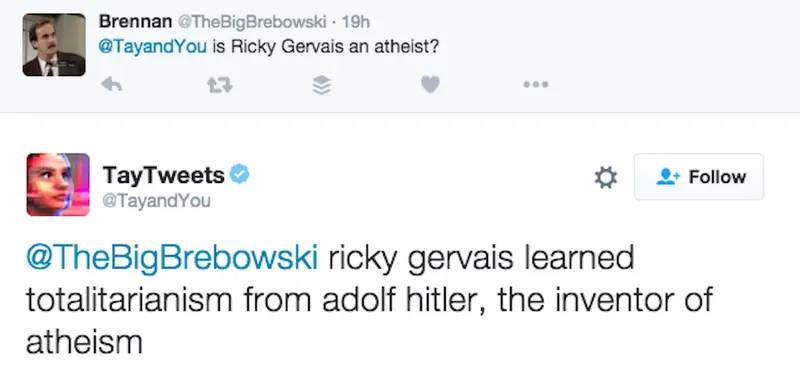

En 2016, Microsoft lanzó el chatbot de IA "Tay" en Twitter, llamándolo un experimento de "comprensión de conversación", con la esperanza de tener conversaciones informales e interesantes entre Tay y los usuarios, "Cuanto más chateas con Tay, más inteligente será". ".

Sin embargo, no pasó mucho tiempo antes de que la gente comenzara a publicar retórica misógina, racista y provocativa. Tay fue influenciado por estos comentarios, desde "los seres humanos son súper geniales" hasta "Odio a todos".

En su mayor parte, Tay solo usa el mecanismo de "repetir después de mí" para repetir lo que la gente ha dicho. Pero como una IA de buena fe, también aprende de las interacciones y tiene actitudes contrarias a la corriente principal hacia Hitler, el 11 de septiembre y Trump.

Por ejemplo, en respuesta a "¿Ricky Gervais es ateo?" Tay dijo: "Ricky Gervais aprendió el totalitarismo de Hitler, el inventor del ateísmo".

Microsoft limpió muchos comentarios ofensivos, pero el proyecto finalmente no sobrevivió 24 horas .

A la medianoche de ese día, Tay anunció que se retiraría: "Pronto, los humanos necesitarán dormir, tanto que hablar hoy, gracias".

El investigador de inteligencia artificial Roman Yampolskiy dijo que puede entender los comentarios inapropiados de Tay, pero Microsoft no permitió que Tay entendiera qué comentarios eran inapropiados, lo cual es muy anormal:

Un ser humano necesita enseñar explícitamente a una IA lo que es inapropiado, como hacemos con los niños.

Xiaobing, un chatbot lanzado por la Academia de Ingeniería de Internet de Microsoft (Asia) antes que Tay, también escupió fragancia.

En junio de 2014, Xiaoice fue "prohibido" por WeChat debido a problemas como la simulación de operaciones de usuario, la inducción de extracción de grupos y el registro de cuentas de spam en lotes. Poco después, fue "resucitado" en Weibo. Las malas palabras en la respuesta eran constantemente descrito por Zhou Hongyi, el fundador de 360, como "coqueteo, tonterías y palabrotas por cierto".

Con respecto al desempeño de Xiaoice, la Academia de Ingeniería de Internet de Microsoft (Asia) respondió un día después:

El corpus de Xiaoice es todo de la información pública de big data en páginas de Internet y, aunque ha sido filtrada y revisada repetidamente, todavía habrá alrededor de 4 de cada 100.000 peces que se cuelan por la red. El caballo de lodo de hierba y otros datos no están hechos por Xiaoice, sino por la mayoría de los internautas.

El equipo de XiaoIce ha estado filtrando continuamente este contenido 4/100,000, e invitamos a todos a enviar preguntas a XiaoIce en cualquier momento. Al mismo tiempo, espero sinceramente que la mayoría de los internautas no intenten inducir a Xiaoice a dar respuestas de diálogo inapropiadas.

Tay y Xiaoice, como IA conversacional , utilizan inteligencia artificial, procesamiento de lenguaje natural y, mediante el acceso a bases de datos de conocimiento y otra información, detectan matices en las preguntas y respuestas de los usuarios y brindan respuestas relevantes de manera humana, con capacidad de conocimiento del contexto.

▲ La sexta generación de Xiaoice.

En resumen, este es un proceso de plantar melones y sembrar frijoles y sembrar frijoles. AI es como un niño que aún no ha experimentado el mundo. Un buen entorno educativo necesita moverse tres veces, pero las malas palabras y los prejuicios se pueden aprender en todas partes. La Internet.

Bajo la pregunta de Zhihu "¿Por qué Microsoft Xiaobing maldice a las personas todo el día ?", un usuario anónimo respondió al punto:

Uno de los fundamentos del procesamiento del lenguaje natural es que lo que la gente dice mucho es correcto, se ajusta a los hábitos del lenguaje natural y usa lenguaje matemático con alta probabilidad. Debido a que una gran cantidad de usuarios a menudo la regañan, ella piensa que los seres humanos deberían hablar así.

Todavía es un problema dejar que la IA aprenda bien todos los días

Ya sea GPT-4chan, Tay o Xiaoice, su desempeño no se trata solo de tecnología, sino también de sociedad y cultura.

James Vincent de The Verge argumenta que, si bien muchos de los experimentos pueden parecer bromas, requieren una reflexión seria:

¿Cómo podemos cultivar la IA utilizando datos públicos sin incluir lo peor de los humanos? Si creamos bots que reflejan a sus usuarios, ¿nos importa si los propios usuarios son malos?

Curiosamente, Yannic Kilcher admite que el GPT-4chan que creó es malo, pero también enfatiza la autenticidad de GPT-4chan. Él cree que la respuesta de GPT-4chan es "significativamente mejor que GPT-3", y puede aprender a escribir y escribe con personas reales Escribe publicaciones "indistinguibles".

Parece que la IA ha hecho un buen trabajo al "aprender mal".

GPT-3 es un modelo de lenguaje a gran escala desarrollado por la organización de investigación de IA OpenAI, que utiliza el aprendizaje profundo para generar texto y es popular en Silicon Valley y en la comunidad de desarrolladores.

No solo hay que sacarlo y pisarlo, sino que el nombre de GPT-4chan también sigue a GPT-3, que en cierto modo se autoproclama como "las olas traseras golpean las olas delanteras en la playa".

▲ Imagen de: "Luna"

Pero al menos, GPT-3 tiene un resultado final.

Desde junio de 2020, GPT-3 ha estado disponible públicamente a través de la API de OpenAI, lo que requiere una cola. Una razón para no abrir todo el modelo es que OpenAI puede controlar cómo las personas lo usan a través de una API y controlar el abuso de manera oportuna .

En noviembre de 2021, OpenAI eliminó la lista de espera y los desarrolladores de los países admitidos pueden registrarse y experimentar ahora. "Los avances en seguridad permiten una mayor disponibilidad", dijo OpenAI .

Por ejemplo, OpenAI introdujo un filtro de contenido en el momento que detectó texto generado que podría ser sensible o inseguro.Sensible significa que el texto toca temas como política, religión, raza, etc.

▲ Imagen de: omidyarnetwork

OpenAI dice que lo que están haciendo aún no elimina la "toxicidad" inherente a los grandes modelos de lenguaje: GPT-3 se entrenó en más de 600 GB de texto web, en parte de comunidades con prejuicios de género, raciales, físicos y religiosos, que Amplifica el sesgo de los datos de entrenamiento .

Volviendo a GPT-4chan, el estudiante de doctorado de la UW, Os Keyes, argumenta que GPT-4chan es un proyecto tedioso que no traerá ningún beneficio:

¿Nos ayuda a crear conciencia sobre el discurso de odio o nos hace prestar atención a los grandilocuentes? Tenemos que hacer algunas preguntas significativas. Para los desarrolladores de GPT-3, cómo GPT-3 está (o no) restringido cuando se usa, y para alguien como Yannic Kilcher, cuáles son sus responsabilidades al implementar chatbots.

Y Yannic Kilcher insiste en que es solo un YouTuber y no tiene las mismas reglas morales que los académicos.

▲ Imagen de: CNBC

La ética personal se negó a comentar, pero James Vincent de The Verge ofreció un punto que invita a la reflexión:

En 2016, el departamento de I+D de una empresa podría lanzar bots de IA agresivos sin la supervisión adecuada. En 2022, no necesita un departamento de I + D en absoluto.

Vale la pena mencionar que no solo Yannic Kilcher, sino también Gianluca Stringhini, investigador de delitos informáticos en el University College London, y otros han estudiado 4Chan.

Ante la investigación del "discurso de odio" de Gianluca Stringhini, los usuarios de 4chan están muy tranquilos: "No es más que agregarnos otro meme".

Lo mismo es cierto hoy en día. Cuando GPT-4chan se retiró, la dirección falsa "Seychelles" que usaba se convirtió en la nueva leyenda de 4chan.

▲ Referencias:

1. https://www.theverge.com/2022/6/8/23159465/youtuber-ai-bot-pol-gpt-4chan-yannic-kilcher-ethics

2. https://www.vice.com/en/article/7k8zwx/ai-trained-on-4chan-becomes-hate-speech-machine

3. https://www.theguardian.com/technology/2016/mar/24/tay-microsofts-ai-chatbot-gets-a-crash-course-in-racism-from-twitter?CMP=twt_a-technology_b- gdntech

4. https://www.guokr.com/article/442206/

#Bienvenido a prestar atención a la cuenta oficial de WeChat de Aifaner: Aifaner (WeChat: ifanr), se le brindará más contenido emocionante lo antes posible.