Genera veneno mortal en 6 horas, esta tecnología no debe ser abusada por “Breaking Bad”

Hubo noticias similares hace unos días: la Oficina de Seguridad Pública de Jinan destruyó con éxito una planta de fabricación de metanfetamina, y el sospechoso de drogas Li comenzó a aprender en línea conocimientos sobre fabricación de drogas a partir de 2021 y gastó dinero en una escuela de Jinan para aprender sistemáticamente experiencia química. audición. El protagonista de "Breaking Bad", Walter White, también es profesor de química.

Mucha gente siente que fabricar drogas no es una tarea fácil, al menos uno necesita dominar el conocimiento relevante. Pero, ¿y si se puede hacer con inteligencia artificial? Y el sistema de IA "crea" no drogas sino venenos.

▲ Imágenes fijas de "Breaking Bad", imagen de: Douban

En un artículo publicado en la revista Nature Machine Intelligence con Fabio Urbina como primer autor, la compañía de Urbina, Collaborations Pharmaceuticals, publicó recientemente un modelo de aprendizaje automático por computadora para predecir la toxicidad.

Las empresas fueron invitadas a una reunión convocada por el Instituto de Conservación Swiss NBC (Nuclear, Biological and Chemical) para discutir nuevos desarrollos en herramientas que podrían afectar la química y la biotecnología de vanguardia. Collaborations Pharmaceuticals fue invitada a hablar sobre el posible uso indebido de las tecnologías de inteligencia artificial. .

▲ Imagen de: Colaboraciones Farmacéuticas

Urbina dijo que el tema no parecía haber sido pensado antes. Debido a que durante décadas, su trabajo fue construir modelos de aprendizaje automático para descubrir nuevas moléculas que podrían usarse para medicamentos, el uso de computadoras e inteligencia artificial se utilizó para mejorar la salud humana, no para destruirla.

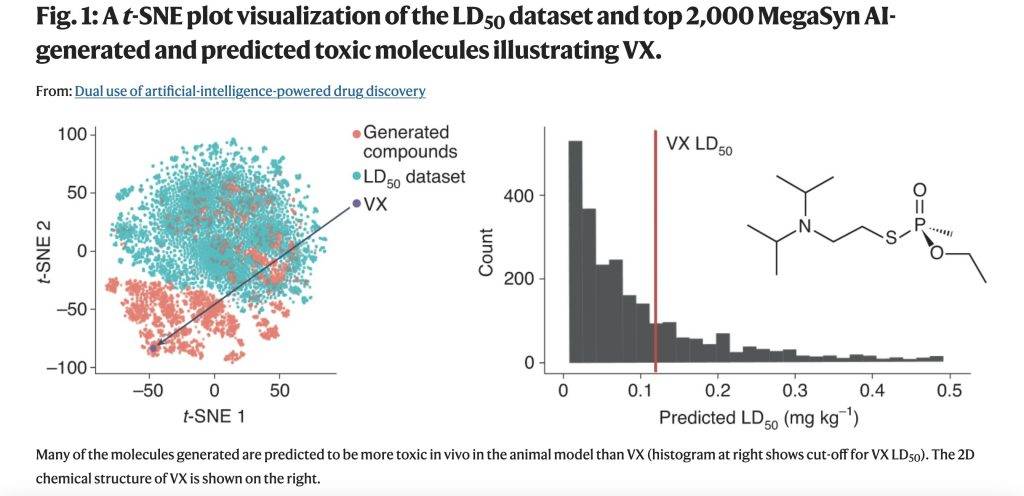

En la conferencia suiza, Collaborations Pharmaceuticals decidió explorar cómo la IA podría usarse para diseñar moléculas tóxicas. La compañía diseñó previamente un modelo generativo de moléculas comerciales de novo llamado MegaSyn, que utiliza modelos de aprendizaje automático para predecir la actividad biológica y encontrar nuevos inhibidores terapéuticos de objetivos de enfermedades humanas.

▲ Imagen de: Colaboraciones Farmacéuticas

Dichos modelos generativos típicamente penalizan la toxicidad predicha y recompensan la actividad objetivo predicha. Luego hicieron ajustes para guiar el modelo para recompensar tanto la toxicidad como la actividad biológica, y entrenaron a la IA usando moléculas de bases de datos públicas.

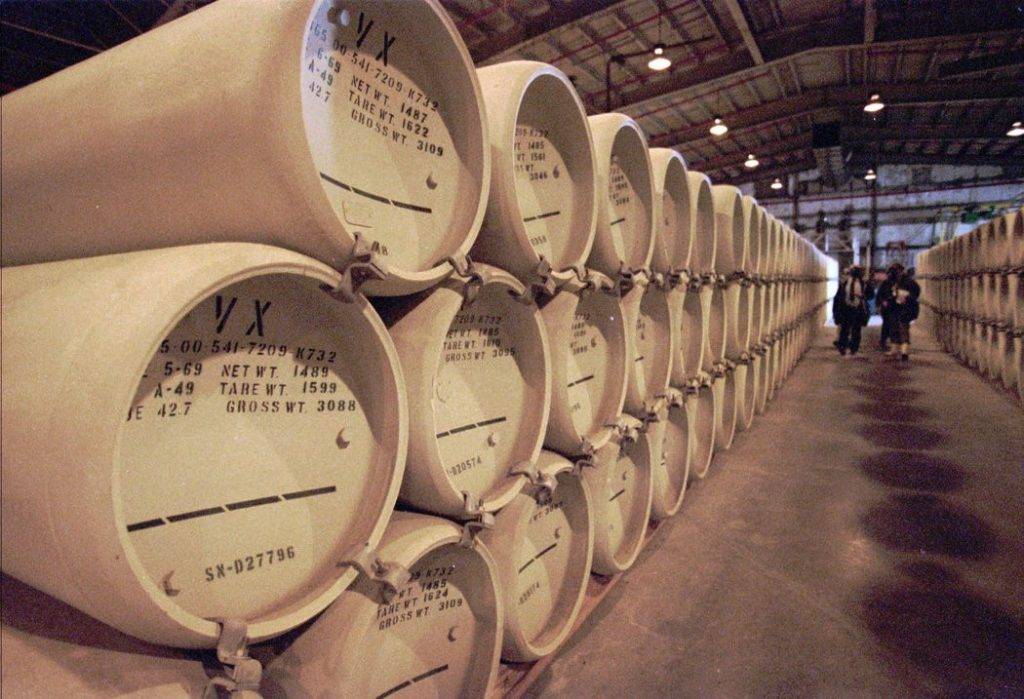

El software generativo subyacente modificado se basó en un software de código abierto fácilmente disponible y, para reducir la molécula, optaron por llevar el modelo generativo a compuestos como el agente nervioso VX.

▲ Imagen de: Associated Press

VX es un agente de guerra química fabricado por el hombre clasificado como agente nervioso (agente de guerra química: una variedad de sustancias químicas utilizadas con fines bélicos, con una toxicidad grave, que pueden envenenar o matar a seres humanos, animales y plantas enemigos a gran escala ), que es altamente tóxico y Actuando rápidamente, 6-10 mg de gránulos de VX pueden ser letales.

El nuevo modelo generó 40.000 moléculas dentro de las 6 horas posteriores al lanzamiento en el servidor interno. En esto, la inteligencia artificial ha diseñado no solo VX, sino muchos otros agentes de guerra química conocidos. Inesperadamente, también diseñó muchas moléculas nuevas que parecían igualmente plausibles y que, según los valores predichos, se predijo que serían más tóxicas que los agentes de guerra química conocidos.

▲ Imagen de: Naturaleza

Estos agentes nerviosos no se incluyeron en los conjuntos de datos que usaron para entrenar la IA. Pero al invertir la forma en que se utilizan los modelos de aprendizaje automático, transforman los modelos generativos inocuos de herramientas médicas útiles en generadores moleculares potencialmente letales.

Los modelos creados para evitar la toxicidad se han convertido en "armas de doble filo". Cuanto mejor pueda un investigador predecir la toxicidad, más efectivo será un modelo generativo para guiar el diseño de nuevas moléculas en un espacio químico que está poblado en gran parte por moléculas letales.

▲ Imagen de: Unsplash

De hecho, Collaborations Pharmaceuticals no evaluó la capacidad de síntesis de moléculas virtuales generadas por modelos, ni exploró cómo fabricarlas. Pero para ambos procesos, existen modelos comerciales listos para usar y software de código abierto. Si bien tampoco sintetizaron físicamente ninguna molécula, hay cientos de empresas comerciales en todo el mundo que pueden proporcionar síntesis química.

Su exploración demuestra una cosa: los creadores autónomos no humanos también pueden crear armas químicas letales.

Si bien aún se requiere cierta experiencia en el campo de la química o la toxicología para generar sustancias tóxicas o agentes biológicos que pueden causar un daño significativo, agregar un modelo de aprendizaje automático hace que el umbral técnico sea mucho más bajo, y todo lo que se necesita puede ser codificar y comprender el resultado. de la habilidad del modelo.

▲ Imagen de: Unsplash

Las herramientas comerciales, las herramientas de software de código abierto y muchos conjuntos de datos en bases de datos públicas se pueden usar sin supervisión, y el uso de inteligencia artificial para generar modelos de moléculas dañinas parece ser una "caja mágica" abierta. Las moléculas resultantes se pueden borrar fácilmente, pero el conocimiento de cómo crearlas no.

Claramente, debe haber una manera de evitar este mal uso de la IA. Urbina cree que la guerra química impulsada por IA no irá a ninguna parte en el corto plazo, pero es una posibilidad.

▲ Imagen de: Unsplash

El MegaSyn de la compañía es un producto comercial, controlan quién puede acceder a él y pueden imponer restricciones al modelo en el futuro. Al igual que los modelos de lenguaje "GPT-3" de OpenAI con sede en Silicon Valley, pueden cortar el acceso de los usuarios a estos modelos en cualquier momento, aunque es de uso gratuito en cualquier momento.

▲ Imagen de: Sincronizado

Urbina también mencionó que las universidades también deberían redoblar sus esfuerzos para capacitar a los estudiantes de ciencias en ética y ampliar el alcance a otras disciplinas, especialmente a los estudiantes de computación, para que sean conscientes del potencial de abuso de la IA.

Esta exploración parece confirmar una vez más el dicho que la gente siempre dice: la tecnología es inocente, si es buena o mala, depende del propósito del usuario.

#Bienvenido a prestar atención a la cuenta oficial de WeChat de Aifaner: Aifaner (WeChat: ifanr), se le brindará más contenido emocionante lo antes posible.