¿Cuál es el futuro chip por el que apuestan Apple, Qualcomm y Google? Filosofía dura

Durante mi experiencia con el Pixel 6 Pro, además de tomar fotos, rara vez sentí algo malo con lo que Google llamó "el teléfono Pixel más inteligente" hasta que una mañana me despertó la alarma de mi teléfono.

A diferencia de la operación de deslizar para cerrar la alarma en un teléfono móvil normal, el Pixel 6 Pro me pide que diga "Snooze (un descanso más)" o "Stop (stop)" para controlar la alarma, y cuando digo "Stop "Cuidado, la alarma del celular que seguía sonando estaba en silencio.

Es una pequeña característica trivial, pero me mantiene de buen humor cada mañana cuando me despierto con mi despertador.

Finalmente, ya no tengo que forzar el sueño para buscar mi teléfono móvil, solo necesito una oración para callar el teléfono móvil que amenaza la vida. Es la primera vez que siento que el teléfono móvil puede "entenderme".

El secreto de "entender las palabras de la gente" se esconde en la humilde TPU.

Computación de IA ubicua

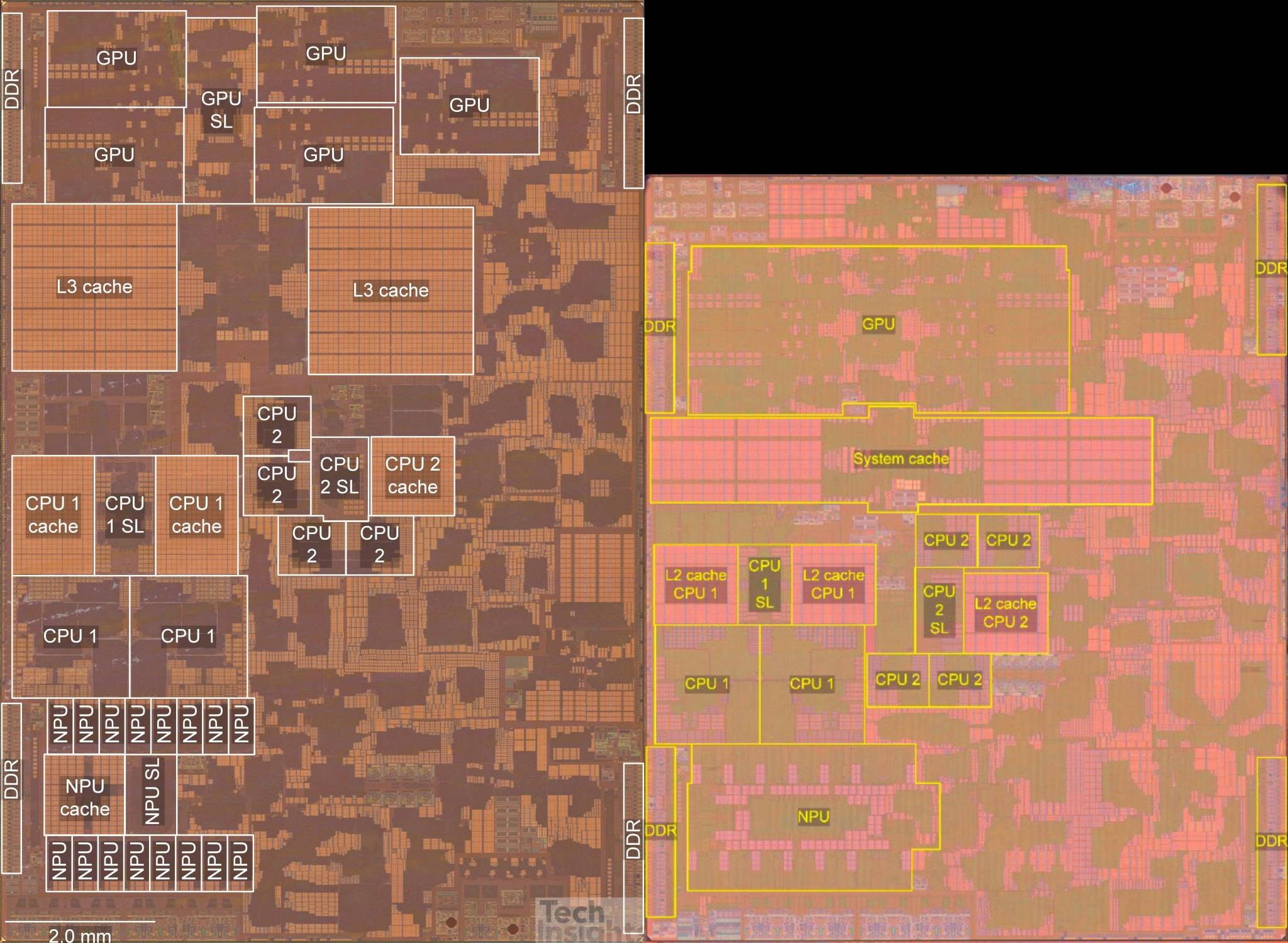

En el SoC del teléfono móvil, la presencia de la NPU siempre es más débil que la de la CPU y la GPU.

Este procesador que se enfoca en las operaciones de redes neuronales ni siquiera tiene un nombre unificado: se llama NPU en el chip Kirin y Neural Engine en el chip biónico de la serie A; Google lo llama TPU y MediaTek cree que se usa para eso. debería llamarse APU para el cálculo de IA…

Aunque estos chips tienen varios nombres y diferentes arquitecturas y principios, sus propósitos son muy similares: acelerar el aprendizaje automático y mejorar el poder de cómputo de inteligencia artificial de los teléfonos móviles.

Si presta atención al rendimiento del procesador del teléfono móvil, encontrará que, ya sea el chip de la serie A del iPhone o el chip insignia Snapdragon de Android, la potencia informática de la CPU se ha mejorado de forma muy limitada en el pasado. dos años, y el fenómeno de "exprimir la pasta de dientes" en el rendimiento es cada vez más grave.

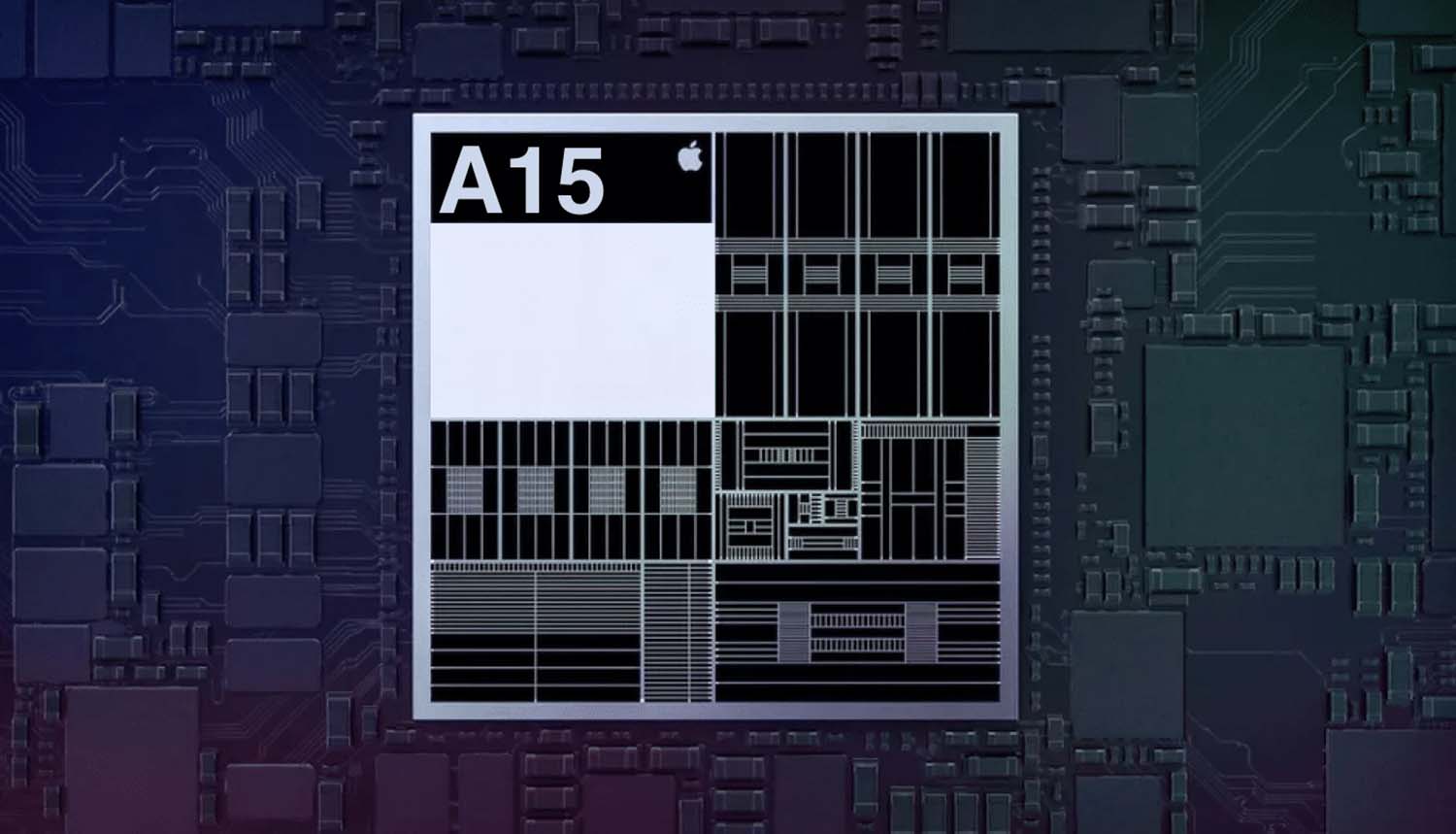

Por el contrario, el poder de cómputo de la IA se ha convertido en un indicador de parámetro que más fabricantes están dispuestos a mencionar. Tomando el chip de la serie A como ejemplo, el chip biónico A14 de Apple casi ha duplicado su potencia informática máxima en comparación con la generación anterior y puede realizar 11 billones de operaciones por segundo.

Un año después, el chip biónico A15 todavía puede aportar una mejora sustancial de más del 40 % sobre esta base, y puede realizar hasta 15,8 billones de operaciones por segundo.

El progreso de la potencia de cómputo de la IA del campo de Android también es muy impresionante.En la lista de pruebas de rendimiento de IA lanzada por la Universidad Tecnológica de Zúrich, la puntuación de rendimiento de IA del Kirin 970, que se introdujo por primera vez con NPU, obtuvo una puntuación 23 600 puntos. Cuatro años después, el chip Google Tensor alcanzó la cima con una puntuación alta de 214 700. , y Kirin 9000 y Snapdragon 888 también lograron alrededor de 160 000 puntos.

Dado que el poder de cómputo de la IA está creciendo casi exponencialmente, ¿por qué es difícil para nosotros sentir algún cambio? ¿La función de IA de la palabra que suena ligeramente avanzada está demasiado lejos de nosotros?

▲ Imagen de: Gadgetmatch

De hecho, cada vez que desbloqueas el teléfono, despiertas al asistente de voz o incluso presionas el obturador, es un contacto cercano con la computación de IA.

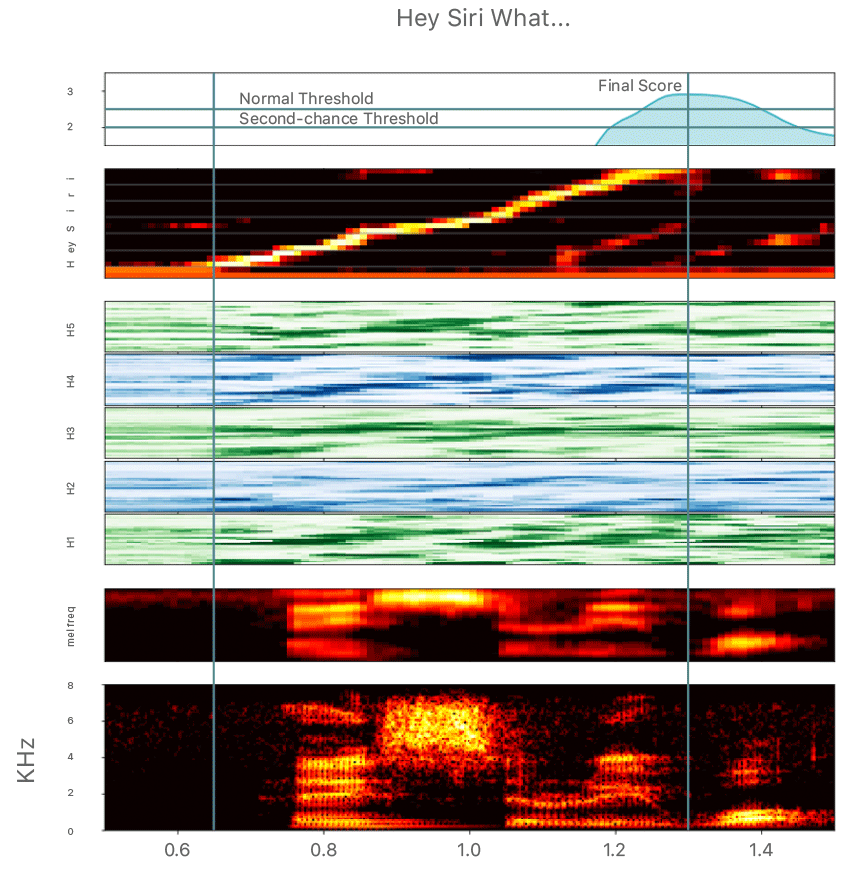

La NPU es como una caja negra, hace que el proceso de cálculo de la IA sea casi inexistente, haciéndote invisible a la tecnología, pero rodeado de una interacción humano-computadora más natural. La evolución del asistente de voz de Google es un buen ejemplo.

Desde que Siri se unió a la función de activación por voz de "Oye, Siri" en 2014, las palabras de activación están casi ligadas al asistente de voz. Cada vez que hablamos con el asistente de voz, tenemos que tomarnos la molestia de llamarlo por su nombre. : Siri, Xiao Ai, Xiao Bu, Xiaoyi… Si el entorno de voz es muy ruidoso, este vergonzoso proceso puede repetirse muchas veces.

▲ La imagen de huella de voz para reconocer la palabra de activación proviene de: Apple

Esto se debe a que, debido a las consideraciones de consumo de energía, el procesador del teléfono móvil no puede desperdiciar la potencia informática para analizar cada oración del usuario en segundo plano durante mucho tiempo. En este momento, un receptor de voz con bajo consumo de energía y que solo reconoce palabras de activación es requerido para trabajar permanentemente.

Cuando se recibe la señal de la palabra de activación, el procesador principal se moviliza para escuchar la siguiente instrucción del usuario.

Sin embargo, aunque esto puede lograr un despertar de voz de baja potencia, todavía está un poco lejos de la forma ideal de los asistentes de inteligencia artificial en las películas de ciencia ficción. Es como si Iron Man dijera "Oye, Jarvis" antes de pelear. la interacción con la computadora es un poco incómoda.

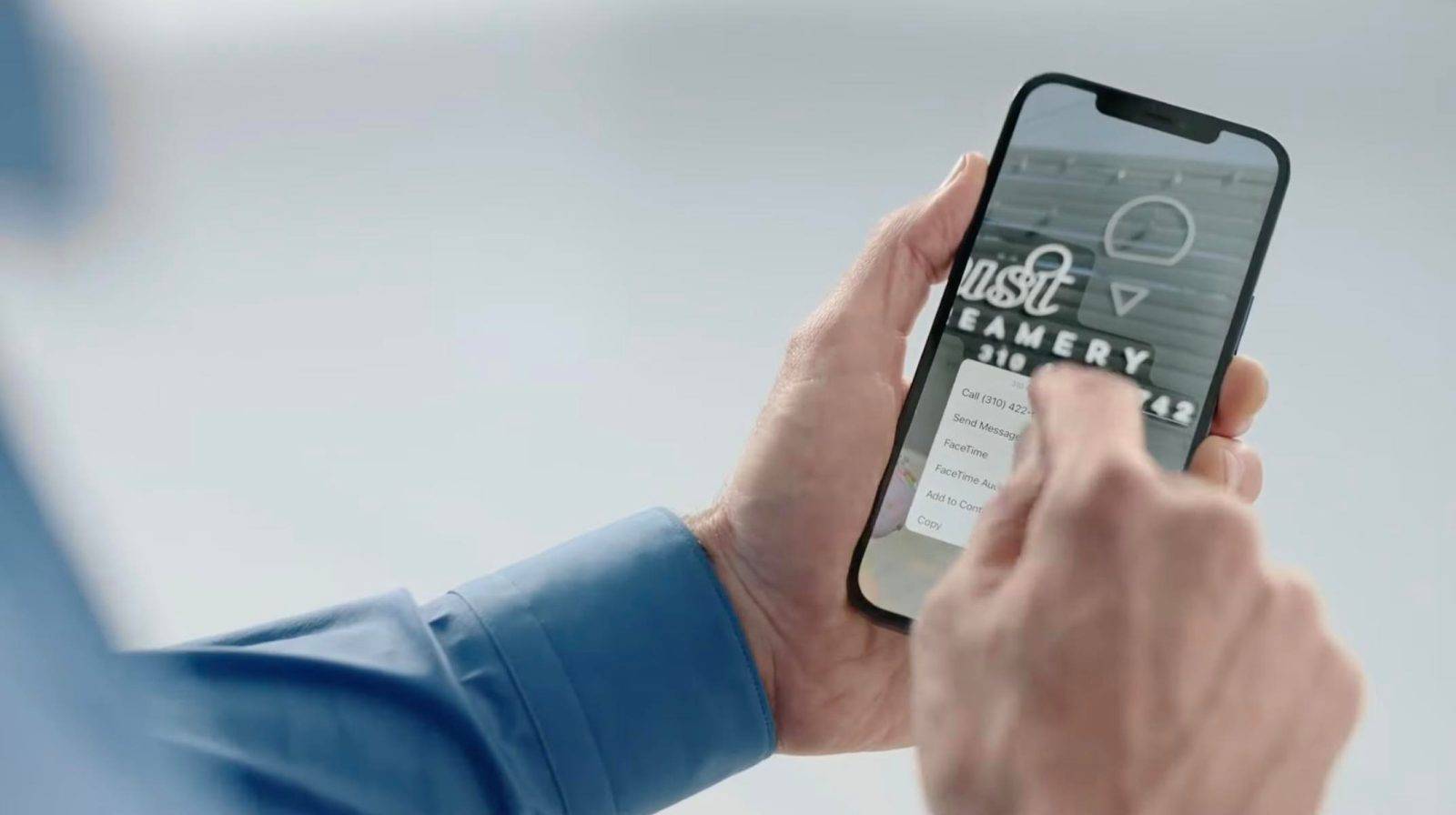

La función "Comandos de acceso directo" de Google en la serie Pixel 6 hace realidad esta interacción natural que existe en las películas de ciencia ficción.

Como se mencionó al comienzo del artículo, los usuarios también pueden activar el Asistente de Google para realizar tareas específicas, como apagar el despertador y responder llamadas sin gritar palabras de activación como "OK Google" a través de las "Instrucciones de acceso directo".

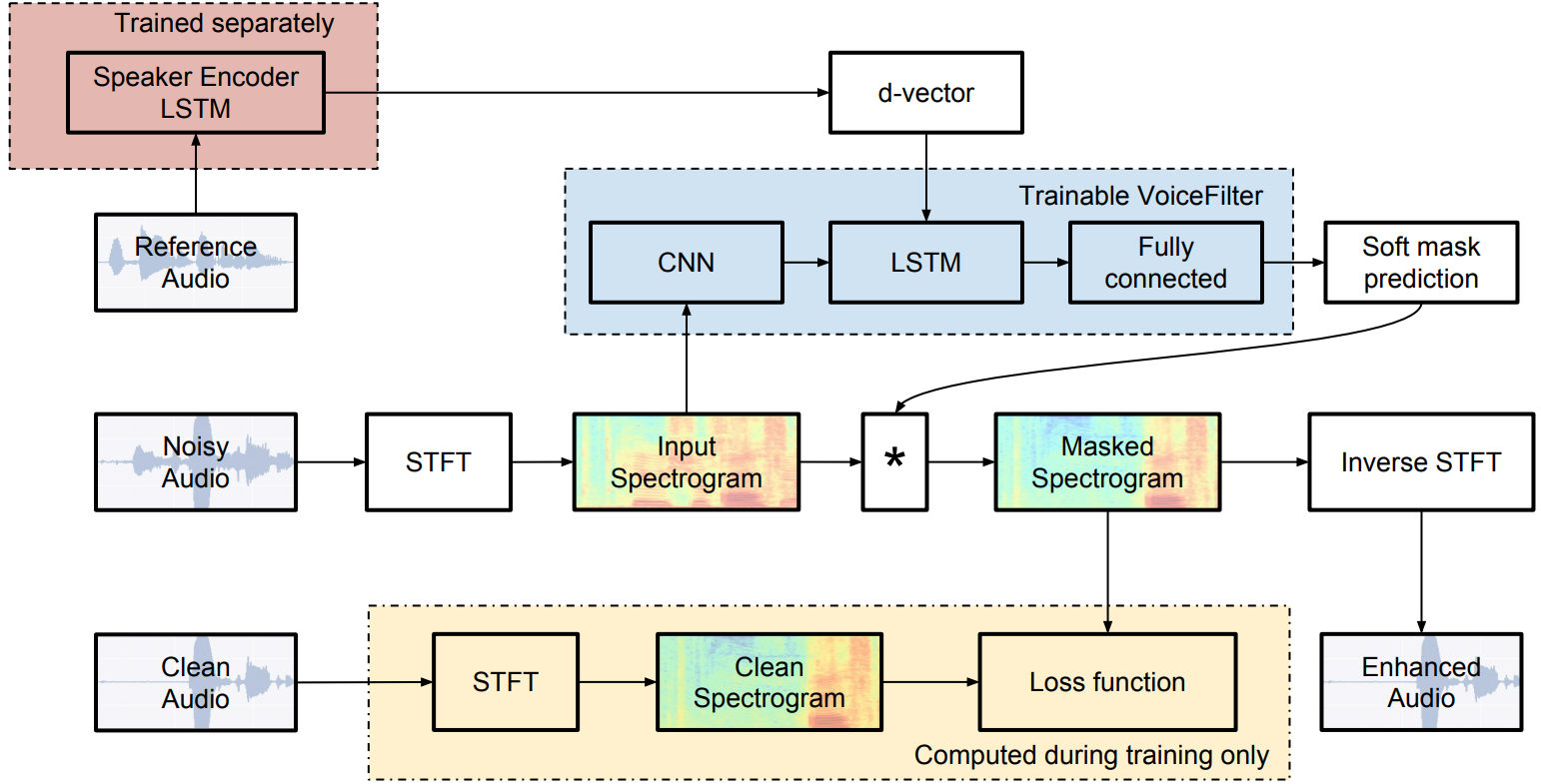

▲ Algoritmo VoiceFilter propuesto por Google Imagen de: Google

Para separar direccionalmente las voces humanas en un entorno de sonido ruidoso, los teléfonos móviles deben tener capacidades de reconocimiento de huellas de voz de mayor precisión y utilizar algoritmos de redes neuronales convolucionales más complejos para capturar y reconocer con precisión la contraseña del usuario.

Y el chip de TPU de Google especialmente diseñado para la informática de IA solo cumple con esta demanda de potencia de cómputo de IA, y esta interacción de voz natural finalmente se realiza en la serie Pixel 6.

La NPU basada en la unidad de procesamiento neuronal es mucho más eficiente que la CPU tradicional en el reconocimiento y procesamiento de imágenes y voz, por lo que los fabricantes de teléfonos móviles pueden desarrollar muchas funciones, como la fotografía computacional y el reconocimiento de texto, para enriquecer las funciones de software del sistema.

En el último iOS15 de Apple, muchas características nuevas están diseñadas en base a motores de computación neuronal, como audio espacial y modo de retrato agregados a FaceTime, extracción y traducción de texto en tiempo real, álbumes de fotos para buscar directamente texto en fotos, operación sin conexión de Siri, etc. .

Dado que estas funciones tienen ciertos requisitos para la potencia informática de la IA, Apple también enfatizó que si el chip SoC no es un modelo posterior del A12 Bionic, incluso si actualiza a iOS15, estas funciones no se pueden experimentar.

Otro ejemplo es la identificación inteligente de fotos de identificación en MIUI13, agregando marcas de agua, protección de privacidad de verificación facial y otras funciones.Los gestos espaciales y la rotación de la cabeza de HarmonyOS también se desarrollan utilizando tecnologías como el reconocimiento de imágenes AI y OCR de texto.

Las funciones de IA han comenzado a convertirse en una parte importante de nuestra experiencia diaria con el teléfono móvil, y la NPU, que originalmente se consideró insignificante, se ha convertido en una parte integral de la experiencia del software del sistema.

¿Por qué necesita chips informáticos de IA?

En comparación con otras partes de los teléfonos móviles, la NPU apareció mucho más tarde.

En septiembre de 2017, Huawei lanzó el Kirin 970 en la exhibición IFA en Berlín, que es el primer SoC con una NPU integrada.Durante el mismo período, Apple lanzó el primer chip biónico A11 equipado con un motor de computación neuronal.Los dos campos prestaron atención. al campo de la computación de IA sorprendentemente sincrónicamente.

La aparición de las funciones de IA puede parecer abrupta, pero en realidad es el resultado de una evolución natural durante el desarrollo de las formas de los teléfonos inteligentes.

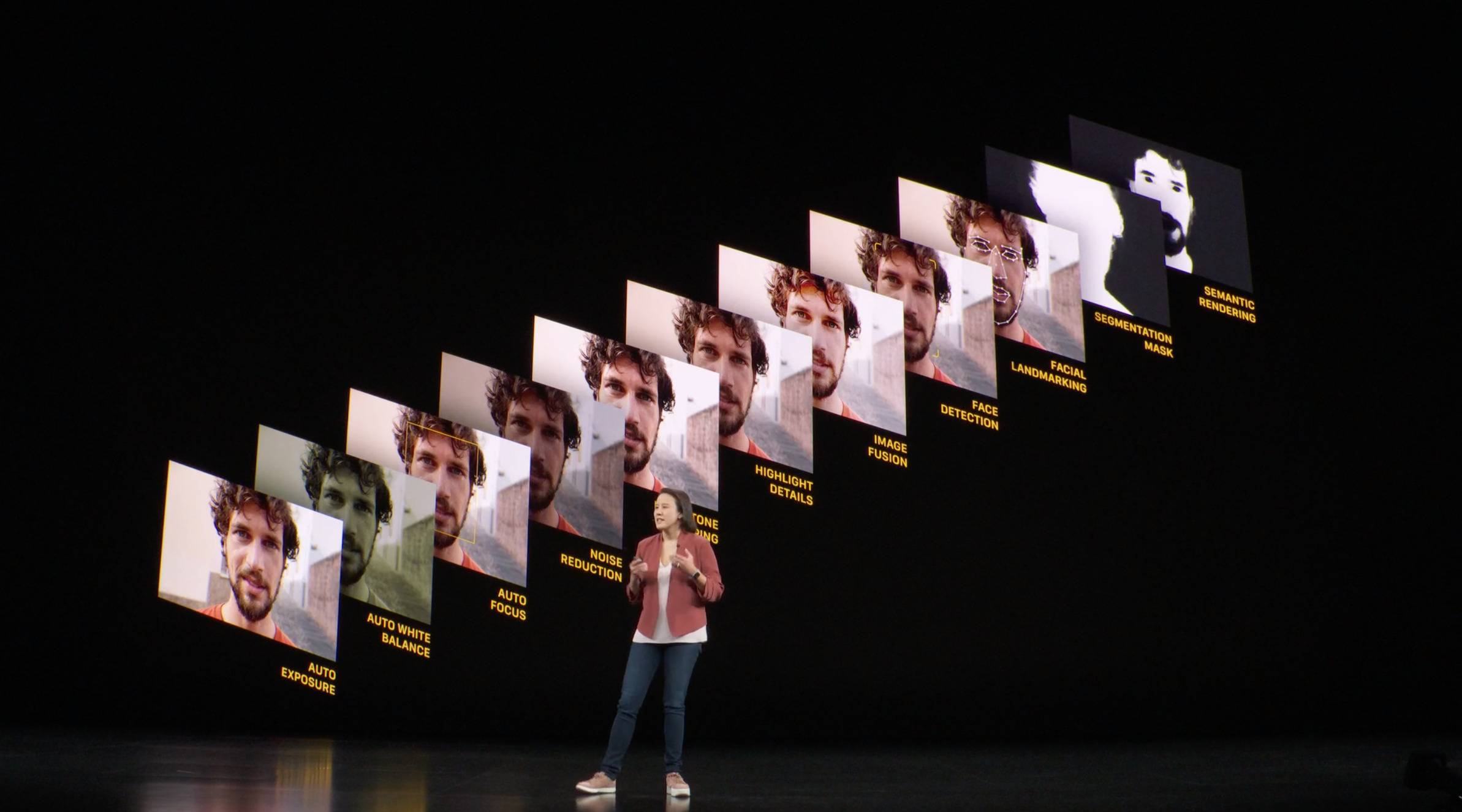

En una entrevista con el vicepresidente de Apple, Tim Millet, sobre los chips de la serie A, la revista Wired mencionó que unos años antes del lanzamiento del iPhone X, algunos ingenieros de Apple propusieron usar algoritmos de aprendizaje automático para hacer que la cámara del iPhone fuera más inteligente.

Es esta idea la que hace posible el iPhone X, que define la forma del iPhone en la próxima década. Cambiar a la pantalla completa del iPhone X requiere un nuevo mecanismo de seguridad para reemplazar el Touch ID que originalmente ocupa la barbilla y no puede quedarse atrás en términos de precisión y velocidad de desbloqueo. reconocimiento.

Cada vez que se enciende el iPhone para desbloquear, la cámara de detección de profundidad ubicada en el flequillo creará un mapa de profundidad a través de miles de puntos, que se comparará con los datos faciales almacenados para completar el desbloqueo, y este proceso de recopilación, creación y la revisión debe ser controlada En un abrir y cerrar de ojos, lo que es más importante, el consumo de energía debe mantenerse en un nivel lo suficientemente bajo.

Según los datos publicados por Apple, los usuarios de iPhone desbloquean un promedio de 80 veces al día. Si es necesario movilizar la CPU o la GPU para realizar operaciones gráficas de alta potencia cada vez que se desbloquean, será un desafío considerable para la duración de la batería de el teléfono.

▲ El proceso de aprendizaje automático

El motor de computación neuronal de arquitectura multinúcleo puede realizar una gran cantidad de operaciones al mismo tiempo y, a través del aprendizaje automático profundo, puede reconocer y juzgar la información del rostro humano como el cerebro humano.Usarlo para realizar el reconocimiento facial tiene un consumo de energía diferente y rendimiento que las CPU tradicionales, pequeña ventaja.

"No podríamos haber hecho esto sin un motor de computación neuronal", dijo Tim Millet en la entrevista.

Con el aumento en la cantidad de núcleos, la potencia informática del motor de cómputo neuronal también mejorará en gran medida y sus aplicaciones serán cada vez más extensas.

Por ejemplo, el motor de cómputo neuronal de 8 núcleos del chip biónico A13 trae funciones de Deep Fusion y modo de escena nocturna a la serie iPhone11, lo que mejora la claridad y los detalles de las fotos a través de múltiples fusiones; llama a varias cámaras al mismo tiempo para lograr una experiencia de zoom suave.

▲ Anatomía del chip biónico A15 y el chip biónico A14, el motor de computación neuronal se concentra en la esquina inferior izquierda

En general, la aparición de NPU, como los motores de computación neuronal, puede compartir la presión informática de la CPU o la GPU. A través de un análisis y cálculo paralelos eficientes de big data, se pueden extraer resultados significativos y se puede utilizar un procesamiento más natural. Capacidad de mejorar nuestra experiencia.

La IA volverá a definir los teléfonos inteligentes

John Giannandrea, vicepresidente senior de aprendizaje automático y estrategia de inteligencia artificial de Apple, mencionó en una entrevista que cree que en los próximos años, todas las funciones de iOS o el ecosistema de software de Apple cambiarán por el aprendizaje automático.

Creo que Apple siempre ha representado la intersección de la creatividad y la tecnología. Cuando piensas en crear experiencias inteligentes, es muy importante integrar verticalmente aplicaciones, marcos, chips… Creo que es un viaje, este es el futuro de los dispositivos informáticos que tenemos, se vuelven inteligentes y luego esta inteligencia será invisible. .

El iPhone original redefinió el teléfono móvil con la interacción de la pantalla táctil y la conexión a Internet en cualquier momento y en cualquier lugar. Desde entonces, el teléfono móvil se ha convertido en una rama de los "teléfonos con funciones" y los "teléfonos inteligentes".

Cuando las funciones de los teléfonos inteligentes convergen, los llamados "inteligentes": enviar WeChat, reproducir música, tomar fotografías, ver noticias, etc., en cierto sentido, vuelven a funcionar.

▲ Imagen de: Gadgetmatch

Es necesario redefinir los teléfonos inteligentes, y la nueva inteligencia debe interpretarse como un teléfono móvil que "entiende a las personas". Puede reconocer el mundo que ve, comprender todos sus comandos y ajustarse dinámicamente de acuerdo con el entorno. Todo esto requiere chips de IA. Obtenga profundamente involucrado.

A medida que la cadena de suministro de hardware para teléfonos móviles se vuelve cada vez más transparente, las diferencias en los componentes principales de los teléfonos móviles de gama media a alta se vuelven cada vez más pequeñas, y las funciones de software reciben cada vez más atención por parte de los fabricantes. , la cadena de suministro de hardware proporciona una buena manera de hacer un Los "ingredientes básicos" de los platos, y si desea cocinar un sabor único, la experiencia de software excelente es el "condimento" clave.

Hoy en día, ya tenemos una pantalla lo suficientemente clara y una cámara que puede fotografiar paisajes a 100 metros de distancia, pero la experiencia de los teléfonos inteligentes no se limita a la visualización y la fotografía convencionales.

![]()

Debería permitirle tomar fotos de longitud multifocal al mismo tiempo, para que no se pierda el paisaje al apresurarse a enfocar; debería poder obtener una vista previa de la escena nocturna o el efecto HDR en tiempo real en el visor, y no esperar más tiempo para obtener imágenes; incluso debería ser un traductor que pueda acompañarlo en sus viajes, incluso si la red es deficiente, puede completar el trabajo de traducción en tiempo real sin conexión.

AI es la mejor opción para ayudarnos a realizar estas funciones Para personalizar las funciones del software más profundamente, más fabricantes de teléfonos móviles como Google y OPPO han comenzado a participar en el diseño de chips NPU para ponerse al día con los precursores como Apple y huawei.

Al mismo tiempo, la poderosa potencia informática de la IA ya no es la patente de los reproductores de chips desarrollados por ellos mismos. Qualcomm Snapdragon 8 y Dimensity 9000 consideran la potencia informática de la IA como el foco de mejora y han superado a Tensor de Google en los puntos de ejecución del rendimiento de la IA. Samsung's El Exynos 2200 lanzado recientemente también se enfoca en mejorar el rendimiento de la NPU, duplicando la mejora.

Los esfuerzos concentrados de los gigantes de los chips en el rendimiento de la IA hacen que parezca que los chips de IA móviles están experimentando la "nueva Ley de Moore".

Además de la velocidad de crecimiento del rendimiento, la popularidad de los chips de IA también es muy impresionante. Según las estadísticas de la agencia de estadísticas Counterpoint, la cantidad de teléfonos móviles con chips de IA incorporados en 2017 solo representó el 3% del mercado. share, y en 2020 esta cifra ha llegado al 35%.

En el futuro, más teléfonos móviles admitirán la computación acelerada por IA, lo que significa que el uso del aprendizaje automático para desarrollar aplicaciones móviles se convertirá en la nueva norma. De hecho, en aplicaciones a nivel nacional como Douyin y WeChat, el uso de la máquina el aprendizaje ya ha aparecido Realice funciones de IA como desenfoque de fondo y recorte con un clic.

Con la participación de los fabricantes de teléfonos móviles y el desarrollo de terceros, las aplicaciones de IA continuarán profundizándose y la forma de los teléfonos inteligentes también puede cambiar en consecuencia, convirtiéndose en una simbiosis de software y hardware para una experiencia placentera.

En ese momento, la batalla por el derecho a hablar en forma de teléfonos inteligentes pasará gradualmente de la gestión de la cadena de suministro al control del big data de los usuarios.

#Bienvenido a prestar atención a la cuenta oficial de WeChat de Aifaner: Aifaner (WeChat: ifanr), se le brindará más contenido emocionante lo antes posible.