AMD está perdiendo la batalla de la IA y es hora de que empiece a preocuparse

Tanto AMD como Nvidia fabrican algunas de las mejores tarjetas gráficas del mercado, pero es difícil negar que Nvidia suele estar a la cabeza. No me refiero sólo a la gran diferencia en la cuota de mercado. En esta generación, es Nvidia la que tiene la GPU gigante que es mejor que todas las demás tarjetas, mientras que AMD aún no tiene una respuesta para la RTX 4090 .

Otra cosa para la que AMD no tiene una respuesta sólida en este momento es la inteligencia artificial. Aunque me estoy cambiando a AMD para uso personal , es difícil ignorar los hechos: Nvidia está ganando la batalla de la IA. ¿Por qué hay una diferencia tan marcada? ¿Será esto un problema mayor para AMD en el futuro?

No todo se trata de jugar

La mayoría de nosotros compramos tarjetas gráficas basándonos en dos cosas: el presupuesto y las capacidades de juego. AMD y Nvidia saben que la gran mayoría de sus tarjetas de consumo de gama alta terminan en plataformas de juego de algún tipo, aunque los profesionales también las adquieren. Aún así, los jugadores y los usuarios ocasionales constituyen la mayor parte de este segmento del mercado.

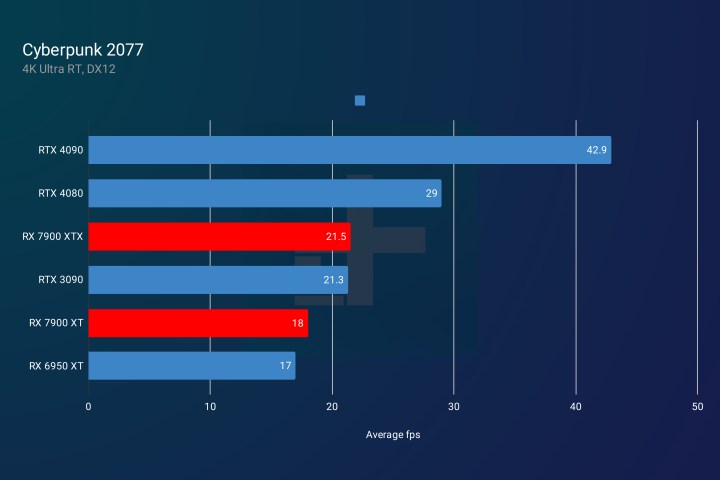

Durante años, el panorama de GPU se centró en Nvidia, pero en las últimas generaciones, AMD hizo grandes avances, tanto que ahora intercambia golpes con Nvidia. Aunque Nvidia lidera el mercado con la RTX 4090, los dos buques insignia RDNA 3 de AMD (la RX 7900 XTX y la RX 7900 XT ) son potentes tarjetas gráficas que a menudo superan ofertas similares de Nvidia, aunque son más económicas que la RTX 4080 .

Si pretendemos que el RTX 4090 no existe, entonces comparar el RTX 4080 y 4070 Ti con el RX 7900 XTX y XT nos dice que las cosas están bastante niveladas en este momento; al menos en lo que a juegos se refiere.

Y luego, llegamos al trazado de rayos y las cargas de trabajo de IA, y aquí es donde AMD cae por un precipicio.

No hay forma de endulzar esto: Nvidia es simplemente mejor para ejecutar tareas generadas por IA que AMD en este momento. No es realmente una opinión, es más un hecho. Este tampoco es el único as bajo la manga.

Tom's Hardware probó recientemente la inferencia de IA en tarjetas Nvidia, AMD e Intel, y los resultados no fueron nada favorables para AMD.

Para comparar las GPU, el probador las comparó en Stable Diffusion, que es una herramienta de creación de imágenes de IA. Lea el artículo fuente si desea conocer todos los detalles técnicos que se incluyeron en la configuración de los puntos de referencia, pero para resumir, Nvidia superó a AMD e Intel Arc A770 lo hizo tan mal que apenas merece una mención.

Incluso hacer que Stable Diffusion se ejecute fuera de una GPU Nvidia parece ser todo un desafío, pero después de algunas pruebas y errores, el evaluador pudo encontrar proyectos que se adaptaran un poco a cada GPU.

Después de la prueba, el resultado final fue que las series RTX 30 y RTX 40 de Nvidia funcionaron bastante bien (aunque después de algunos ajustes para la última). La línea RDNA 3 de AMD también se mantuvo bien, pero las tarjetas RDNA 2 de última generación fueron bastante mediocres. Sin embargo, incluso la mejor tarjeta de AMD estuvo muy por detrás de Nvidia en estos puntos de referencia, lo que demuestra que Nvidia es simplemente más rápida y mejor para abordar tareas relacionadas con la IA.

Las tarjetas Nvidia son la opción ideal para los profesionales que necesitan una GPU para cargas de trabajo de inteligencia artificial o aprendizaje automático. Algunas personas pueden comprar una de las tarjetas de consumo y otras pueden elegir un modelo de estación de trabajo en su lugar, como la confusamente llamada RTX 6000 , pero el hecho es que AMD a menudo ni siquiera está en el radar cuando se construyen tales plataformas.

No pasemos por alto el hecho de que Nvidia también tiene una gran ventaja sobre AMD en aspectos como el trazado de rayos y el supermuestreo de aprendizaje profundo (DLSS) . En nuestros propios puntos de referencia, descubrimos que Nvidia aún lidera el trazado de rayos sobre AMD, pero al menos el Equipo Rojo parece estar dando pasos en la dirección correcta.

Esta generación de GPU es la primera en la que se está cerrando la brecha del trazado de rayos. De hecho, la RX 7900 XTX de AMD supera a la RTX 4070 Ti de Nvidia en ese sentido. Sin embargo, las GPU Ada Lovelace de Nvidia tienen otra ventaja en forma de DLSS 3 , una tecnología que copia fotogramas completos, en lugar de solo píxeles, utilizando IA. Una vez más, AMD se está quedando atrás.

Nvidia tiene una larga historia de IA

Las tarjetas gráficas AMD y Nvidia son muy diferentes a nivel arquitectónico, por lo que es imposible compararlas por completo. Sin embargo, una cosa que sí sabemos es que las tarjetas de Nvidia están optimizadas para IA en términos de su estructura misma, y así ha sido durante años.

Las últimas GPU de Nvidia están equipadas con núcleos de arquitectura de dispositivo unificado de cómputo (CUDA), mientras que las tarjetas AMD tienen unidades de cómputo (CU) y procesadores de flujo (SP). Nvidia también tiene Tensor Cores que ayudan al rendimiento de los algoritmos de aprendizaje profundo, y con Tensor Core Sparsity, también ayudan a la GPU a omitir cálculos innecesarios. Esto reduce el tiempo que necesita la GPU para realizar ciertas tareas, como entrenar redes neuronales profundas.

Los núcleos CUDA son una cosa, pero Nvidia también ha creado una plataforma informática paralela con el mismo nombre, a la que solo se puede acceder con tarjetas gráficas Nvidia. Las bibliotecas CUDA permiten a los programadores aprovechar la potencia de las GPU Nvidia para ejecutar algoritmos de aprendizaje automático mucho más rápido.

El desarrollo de CUDA es lo que realmente diferencia a Nvidia de AMD. Si bien AMD realmente no tenía una buena alternativa, Nvidia invirtió mucho en CUDA y, a su vez, la mayor parte del progreso de la IA en los últimos años se realizó utilizando bibliotecas CUDA.

AMD ha trabajado un poco en sus propias alternativas, pero es bastante reciente si lo comparas con los años de experiencia que ha tenido Nvidia. La plataforma Radeon Open Compute de AMD (ROCm) permite a los desarrolladores acelerar las cargas de trabajo de cómputo y aprendizaje automático. Bajo ese ecosistema, ha lanzado un proyecto llamado GPUFORT .

GPUFORT es el esfuerzo de AMD para ayudar a los desarrolladores a pasar de las tarjetas Nvidia a las propias GPU de AMD. Desafortunadamente para AMD, las bibliotecas CUDA de Nvidia son mucho más compatibles con algunos de los marcos de aprendizaje profundo más populares, como TensorFlow y PyTorch.

A pesar de los intentos de AMD por ponerse al día, la brecha se amplía cada año a medida que Nvidia sigue dominando el panorama de la IA y el ML.

el tiempo se acaba

La inversión de Nvidia en IA fue ciertamente sólida. Dejó a Nvidia con una línea de GPU para juegos en auge junto con una poderosa gama de tarjetas capaces de realizar tareas relacionadas con IA y ML. AMD aún no ha llegado.

Aunque AMD parece estar tratando de optimizar sus tarjetas en el lado del software con núcleos de IA aún sin usar en sus últimas GPU, no tiene el ecosistema de software que Nvidia ha construido.

Sin embargo, AMD juega un papel crucial como el único competidor serio de Nvidia. No puedo negar que AMD ha hecho grandes avances tanto en los mercados de GPU como de CPU en los últimos años. Se las arregló para salir de la irrelevancia y convertirse en una fuerte alternativa a Intel, haciendo que algunos de los mejores procesadores estén disponibles en este momento. Sus tarjetas gráficas ahora también son competitivas, incluso si es solo para juegos. A nivel personal, me he inclinado por AMD en lugar de Nvidia porque estoy en contra del enfoque de precios de Nvidia en las últimas dos generaciones. Aún así, eso no compensa la falta de presencia de IA de AMD.

Es muy visible en programas como ChatGPT que la IA está aquí para decir , pero también está presente en muchas otras cosas que pasan desapercibidas para la mayoría de los usuarios de PC. En una PC para juegos, la IA funciona en segundo plano realizando tareas como la optimización en tiempo real y las medidas antitrampas en los juegos. Los no jugadores también ven mucha IA a diario, porque la IA se encuentra en los siempre presentes chatbots, asistentes personales basados en voz, aplicaciones de navegación y dispositivos domésticos inteligentes.

A medida que la IA impregna cada vez más nuestra vida diaria y se necesitan computadoras para realizar tareas que solo aumentan en complejidad, también se espera que las GPU se mantengan al día. AMD tiene una tarea difícil por delante, pero si no se toma en serio la IA, puede estar condenado a nunca ponerse al día.