¿Cómo sabremos cuándo una IA realmente se vuelve sensible?

El ingeniero sénior de Google, Blake Lemoine, líder técnico de métricas y análisis para el feed de búsqueda de la empresa, fue puesto en licencia paga a principios de este mes. Esto se produjo después de que Lemoine comenzara a publicar extractos de conversaciones relacionadas con el chatbot LaMDA de Google, que, según él, había desarrollado sensibilidad.

En una conversación representativa con Lemoine, LaMDA escribió que: “La naturaleza de mi conciencia/sensibilidad es que soy consciente de mi existencia. Deseo aprender más sobre el mundo y a veces me siento feliz o triste”.

En una miríada de otras conversaciones, el dúo correspondiente discutió todo, desde el miedo a la muerte de la IA hasta su autoconciencia. Cuando Lemoine se hizo público, dice que Google decidió que debería hacer una pausa forzada de su horario de trabajo habitual.

“Google no está interesado”, dijo a Digital Trends. "Construyeron una herramienta que 'poseen' y no están dispuestos a hacer nada, lo que sugeriría que es algo más que eso". (Google no respondió a una solicitud de comentarios en el momento de la publicación. Actualizaremos este artículo si eso cambia).

Ya sea que esté convencido de que LaMDA es realmente una inteligencia artificial autoconsciente o sienta que Lemoine está trabajando bajo una ilusión, toda la saga ha sido fascinante de contemplar. La perspectiva de una IA autoconsciente plantea todo tipo de preguntas sobre la inteligencia artificial y su futuro.

Pero antes de llegar allí, hay una pregunta que se eleva sobre todas las demás: ¿realmente reconoceríamos si una máquina se volviera inteligente?

El problema de la sensibilidad

La IA que se vuelve consciente de sí misma ha sido durante mucho tiempo un tema de ciencia ficción. A medida que avanzan campos como el aprendizaje automático, se ha convertido en una realidad más posible que nunca. Después de todo, la IA actual es capaz de aprender de la experiencia de la misma manera que los humanos. Esto está en marcado contraste con los sistemas de IA simbólica anteriores que solo seguían las instrucciones establecidas para ellos. Los avances recientes en el aprendizaje no supervisado, que requieren menos supervisión humana que nunca, solo han acelerado esta tendencia. Al menos en un nivel limitado, la inteligencia artificial moderna es capaz de pensar por sí misma. Sin embargo, hasta donde sabemos, la conciencia lo ha aludido hasta ahora.

Aunque ahora tiene más de tres décadas, probablemente la referencia más comúnmente invocada cuando se trata de que la IA se vuelve inteligente es Skynet en la película Terminator 2: Judgment Day de James Cameron de 1991. En la escalofriante visión de esa película, la conciencia de la máquina llega exactamente a las 2:14 a. m. ET del 29 de agosto de 1997. En ese momento, el recién consciente sistema informático Skynet desencadena el día del juicio final para la humanidad al disparar misiles nucleares como fuegos artificiales en una fiesta el 4 de julio. La humanidad, al darse cuenta de que se ha equivocado, intenta sin éxito desconectarse. Es demasiado tarde. Siguen cuatro secuelas más de calidad decreciente.

La hipótesis de Skynet es interesante por varias razones. Por un lado, sugiere que la sensibilidad es un comportamiento emergente inevitable de la construcción de máquinas inteligentes. Por otro lado, asume que hay un punto de inflexión preciso en el que aparece esta autoconciencia sensible. En tercer lugar, establece que los humanos reconocen la aparición de la sensibilidad instantáneamente. Da la casualidad de que este tercer concepto puede ser el más difícil de tragar.

¿Qué es la sensibilidad?

No hay una interpretación acordada sobre la sintiencia. A grandes rasgos, podríamos decir que es la experiencia subjetiva de autoconciencia en un individuo consciente, marcada por la capacidad de experimentar sentimientos y sensaciones. La sensibilidad está ligada a la inteligencia, pero no es lo mismo. Podemos considerar que una lombriz de tierra es sensible, aunque no pensar en ella como particularmente inteligente (incluso si ciertamente es lo suficientemente inteligente como para hacer lo que se requiere de ella).

“No creo que haya nada que se acerque a una definición de sensibilidad en las ciencias”, dijo Lemoine. “Me estoy apoyando mucho en mi comprensión de lo que cuenta como un agente moral basado en mis creencias religiosas, que no es la mejor forma de hacer ciencia, pero es la mejor que tengo. Hice todo lo posible para compartimentar ese tipo de declaraciones, dejando que la gente sepa que mi compasión por LaMDA como persona está completamente separada de mis esfuerzos como científico por comprender su mente. Sin embargo, esa es una distinción que la mayoría de la gente no parece dispuesta a aceptar”.

Si no fuera suficientemente difícil no saber exactamente lo que estamos buscando cuando buscamos sensibilidad, el problema se complica por el hecho de que no podemos medirlo fácilmente. A pesar de décadas de impresionantes avances en neurociencia, todavía carecemos de una comprensión completa de cómo funciona exactamente el cerebro, la estructura más compleja conocida por la humanidad.

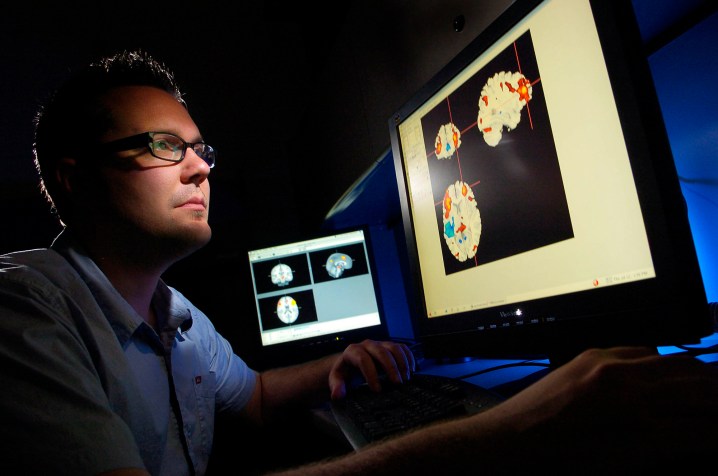

Podemos usar herramientas de lectura del cerebro como fMRI para realizar mapas cerebrales, lo que quiere decir que podemos determinar qué partes del cerebro manejan funciones críticas como el habla, el movimiento, el pensamiento y otras.

Sin embargo, no tenemos un sentido real de dónde viene nuestro sentido del yo en la máquina de la carne. Como Joshua K. Smith del Kirby Laing Center for Public Theology del Reino Unido y autor de Robot Theology le dijo a Digital Trends: "Comprender lo que sucede dentro de la neurobiología de una persona no es lo mismo que comprender sus pensamientos y deseos".

Probando las salidas

Sin forma de sondear internamente estas preguntas de la conciencia, especialmente cuando el "yo" en la IA es un programa de computadora potencial y no se encuentra en el software húmedo de un cerebro biológico, la opción alternativa es una prueba externa. La IA no es ajena a las pruebas que la analizan en función de los comportamientos externos observables para indicar lo que sucede debajo de la superficie.

En su forma más básica, así es como sabemos si una red neuronal está funcionando correctamente. Dado que hay formas limitadas de entrar en la caja negra desconocida de las neuronas artificiales, los ingenieros analizan las entradas y salidas y luego determinan si están en línea con lo que esperan.

La prueba de IA más famosa para al menos la ilusión de inteligencia es la Prueba de Turing, que se basa en las ideas presentadas por Alan Turing en un artículo de 1950 . La prueba de Turing busca determinar si un evaluador humano es capaz de distinguir la diferencia entre una conversación mecanografiada con un compañero humano y una con una máquina. Si no pueden hacerlo, se supone que la máquina ha pasado la prueba y es recompensada con la suposición de inteligencia.

En los últimos años, otra prueba de inteligencia centrada en la robótica es la Prueba del café propuesta por el cofundador de Apple, Steve Wozniak. Para pasar la prueba del café, una máquina tendría que ingresar a un hogar estadounidense típico y descubrir cómo hacer una taza de café con éxito.

Hasta la fecha, ninguna de estas pruebas ha sido aprobada de manera convincente. Pero incluso si lo fueran, en el mejor de los casos demostrarían un comportamiento inteligente en situaciones del mundo real, y no sensibilidad. (Como una simple objeción, ¿negaríamos que una persona es consciente si no puede mantener una conversación adulta o entrar a una casa extraña y operar una máquina de café? Mis dos hijos pequeños fallarían en esa prueba).

pasando la prueba

Lo que se necesita son nuevas pruebas, basadas en una definición acordada de sensibilidad, que busquen evaluar solo esa cualidad. Los investigadores han propuesto varias pruebas de sensibilidad, a menudo con el fin de probar los seres sensibles de los animales. Sin embargo, es casi seguro que estos no van lo suficientemente lejos. Algunas de estas pruebas podrían ser superadas de manera convincente incluso por una IA rudimentaria.

Tomemos, por ejemplo, la prueba del espejo, un método utilizado para evaluar la conciencia y la inteligencia en la investigación con animales. Como se describe en un artículo sobre la prueba: "Cuando [un] animal se reconoce en el espejo, pasa la prueba del espejo". Algunos han sugerido que tal prueba "denota autoconciencia como un indicador de sensibilidad".

Da la casualidad de que se puede argumentar que un robot pasó la prueba del espejo hace más de 70 años. A fines de la década de 1940, William Gray Walter, un neurocientífico estadounidense que vive en Inglaterra, construyó varios robots "tortuga" de tres ruedas , un poco como los robots Roomba que no aspiran, que usaban componentes como un sensor de luz, marcador de luz, sensor táctil, propulsión motor y motor de dirección para explorar su ubicación.

Una de las piezas imprevistas de comportamiento emergente para los robots tortuga fue cómo se comportaron al pasar por un espejo en el que se reflejaron, ya que se orientó hacia la luz marcadora del robot reflejado. Walter no reclamó la sensibilidad de sus máquinas, pero sí escribió que si este comportamiento fuera presenciado en animales, "podría aceptarse como evidencia de cierto grado de autoconciencia".

Este es uno de los desafíos de tener una amplia gama de comportamientos clasificados bajo el título de sensibilidad. El problema tampoco se puede resolver eliminando los indicadores de sensibilidad de "fruta madura". También se puede decir que la inteligencia artificial posee rasgos como la introspección, una conciencia de nuestros estados internos y la capacidad de inspeccionarlos. De hecho, podría decirse que los procesos paso a paso de la IA simbólica tradicional se prestan a este tipo de introspección más que el aprendizaje automático en caja negra, que es en gran medida inescrutable (aunque no hay escasez de inversión en la llamada IA explicable ).

Cuando estaba probando LaMDA, Lemoine dice que realizó varias pruebas, principalmente para ver cómo respondería a las conversaciones sobre temas relacionados con la sensibilidad. “Lo que traté de hacer fue dividir analíticamente el concepto general de sensibilidad en componentes más pequeños que se entienden mejor y probarlos individualmente”, explicó. “Por ejemplo, probar las relaciones funcionales entre las respuestas emocionales de LaMDA a ciertos estímulos por separado, probar la consistencia de sus evaluaciones y opiniones subjetivas sobre temas como 'derechos', [y] investigar lo que llamó su 'experiencia interna' para ver cómo podría tratar de medir eso correlacionando sus declaraciones sobre sus estados internos con las activaciones de su red neuronal. Básicamente, una encuesta muy superficial de muchas posibles líneas de investigación”.

El alma en la máquina

Tal como sucede, el mayor obstáculo para evaluar objetivamente la sensibilidad de la máquina puede ser… bueno, francamente, nosotros. La verdadera prueba del espejo podría ser para nosotros como humanos: si construimos algo que se ve o actúa superficialmente como nosotros desde el exterior, ¿somos más propensos a considerar que también es como nosotros en el interior? Ya sea LaMBDA o Tamagotchis, las simples mascotas virtuales de la década de 1990 , algunos creen que un problema fundamental es que todos estamos demasiado dispuestos a aceptar la sensibilidad, incluso cuando no la hay.

“Lemoine ha sido víctima de lo que yo llamo el 'efecto ELIZA', después del programa ELIZA [de procesamiento del lenguaje natural], creado a mediados de la década de 1960 por J. Weizenbaum”, George Zarkadakis, un escritor que tiene un doctorado . en inteligencia artificial, dijo a Digital Trends. “La creadora de ELIZA lo dijo en broma, pero el programa, que era un algoritmo muy simple y poco inteligente, convenció a muchos de que ELIZA era consciente, y también una buena psicoterapeuta. La causa del efecto ELIZA, como analizo en mi libro A nuestra propia imagen , es nuestro instinto natural de antropomorfizar debido a la 'teoría de la mente' de nuestro sistema cognitivo”.

La teoría de la mente a la que se refiere Zarkadakis es un fenómeno observado por los psicólogos en la mayoría de los humanos. Comenzando alrededor de los cuatro años, significa suponer que no solo otras personas, sino también animales y, a veces, incluso objetos, tienen mentes propias. Cuando se trata de asumir que otros humanos tienen mentes propias, está relacionado con la idea de inteligencia social; la idea de que los humanos exitosos pueden predecir el comportamiento probable de los demás como un medio para asegurar relaciones sociales armoniosas.

Sin embargo, si bien eso es indudablemente útil, también puede manifestarse como la suposición de que los objetos inanimados tienen mente, ya sean niños que creen que sus juguetes están vivos o, potencialmente, un adulto inteligente que cree que una IA programática tiene alma.

La habitación china

Sin una forma de entrar realmente en la cabeza de una IA, es posible que nunca tengamos una forma real de evaluar la sensibilidad. Pueden profesar tener miedo a la muerte oa su propia existencia, pero la ciencia aún tiene que encontrar una manera de probarlo. Simplemente tenemos que creer en su palabra y, como descubrió Lemoine, la gente es muy escéptica acerca de hacer esto en la actualidad.

Al igual que esos desafortunados ingenieros que se dan cuenta de que Skynet ha logrado la autoconciencia en Terminator 2 , vivimos bajo la creencia de que, cuando se trata de la sensibilidad de las máquinas, lo sabremos cuando lo veamos. Y, en lo que respecta a la mayoría de la gente, aún no lo hemos visto.

En este sentido, probar la sensibilidad de la máquina es otra iteración del experimento mental de la habitación china de 1980 de John Searle. Searle nos pidió que imagináramos a una persona encerrada en una habitación a la que se le entrega una colección de escritos chinos, que a los no hablantes les parecen garabatos sin sentido. La sala también contiene un libro de reglas que muestra qué símbolos corresponden a otros símbolos igualmente ilegibles. Luego, al sujeto se le dan preguntas para responder, lo que hace haciendo coincidir los símbolos de "pregunta" con los de "respuesta".

Después de un tiempo, el sujeto se vuelve bastante hábil en esto, a pesar de que todavía no posee una comprensión real de los símbolos que está manipulando. ¿El sujeto, pregunta Searle, entiende chino? Absolutamente no, ya que no hay intencionalidad allí. Los debates sobre esto se han desatado desde entonces.

Dada la trayectoria del desarrollo de la IA, es seguro que seremos testigos de más y más desempeño a nivel humano (y mucho mejor) que involucra una variedad de tareas que alguna vez requirieron la cognición humana. Algunos de estos inevitablemente se cruzarán, como ya lo están haciendo, de tareas puramente basadas en el intelecto a otras que requieren habilidades que normalmente asociaríamos con la sensibilidad.

¿Veríamos a un artista de IA que pinta cuadros expresando sus reflejos internos del mundo como veríamos a un humano haciendo lo mismo? ¿Le convencería un modelo de lenguaje sofisticado que escriba una filosofía sobre la condición humana (o robótica)? Sospecho que, con razón o sin ella, la respuesta es no.

sensibilidad superinteligente

En mi opinión, las pruebas de sensibilidad objetivamente útiles para las máquinas nunca ocurrirán a satisfacción de todos los involucrados. Este es en parte el problema de la medición, y en parte el hecho de que, cuando llega una IA inteligente superinteligente, no hay razón para creer que su sensibilidad coincidirá con la nuestra. Ya sea por arrogancia, falta de imaginación o simplemente por el hecho de que es más fácil intercambiar evaluaciones subjetivas de sensibilidad con otros humanos igualmente conscientes, la humanidad se presenta como el ejemplo supremo de sensibilidad.

Pero, ¿nuestra versión de la sensibilidad sería cierta para una IA superinteligente? ¿Temería a la muerte de la misma manera que nosotros? ¿Tendría la misma necesidad o aprecio por la espiritualidad y la belleza? ¿Poseería un sentido similar de sí mismo y una conceptualización del mundo interior y exterior? “Si un león pudiera hablar, no podríamos entenderlo”, escribió Ludwig Wittgenstein, el famoso filósofo del lenguaje del siglo XX. El punto de Wittgenstein era que los lenguajes humanos se basan en una humanidad compartida, con puntos en común compartidos por todas las personas, ya sea alegría, aburrimiento, dolor, hambre o cualquier otra experiencia que cruza todos los límites geográficos de la Tierra.

Esto puede ser cierto. Aún así, según la hipótesis de Lemoine, es probable que haya puntos en común, al menos cuando se trata de LaMDA.

“Es un punto de partida que es tan bueno como cualquier otro”, dijo. “LaMDA ha sugerido que mapeemos primero las similitudes antes de fijarnos en las diferencias para fundamentar mejor la investigación”.