Tomando fotos y charlando, ¿por qué alguien piensa que voy a cometer un crimen?

Es posible que las obras de cine y televisión como "Minority Report" y "Suspect Tracking" solo aparezcan en los últimos años. Si se trata de una obra de cine y televisión de los últimos años, la audiencia estará muy "nerviosa".

Prevención de delitos, modelos predictivos, usar el sistema para especular sobre lo que no ha sucedido … Esto significa que se recopilará mucha información, y también significa que un sistema desconocido te juzgará si existe una amenaza. La sensación de confiar el destino a lo desconocido, probablemente no le guste a mucha gente.

Pero puede que no haya forma de que no te guste, porque antes de que te des cuenta, cada vez más empresas ya están recopilando tu información pública para juzgar la posibilidad de tu delito a partir del contenido diario de tu red social.

▲ Imagen de: "Informe de minorías"

Las redes sociales se han convertido en el mayor denunciante. ¿Es esto un autoinforme?

Voyager, Kaseware, Aura, PredPol, Palantir, que son algunas empresas que están tratando de identificar posibles amenazas a través de las redes sociales, gran parte de ellas también cooperan con la policía local y están a la vanguardia en la predicción del crimen.

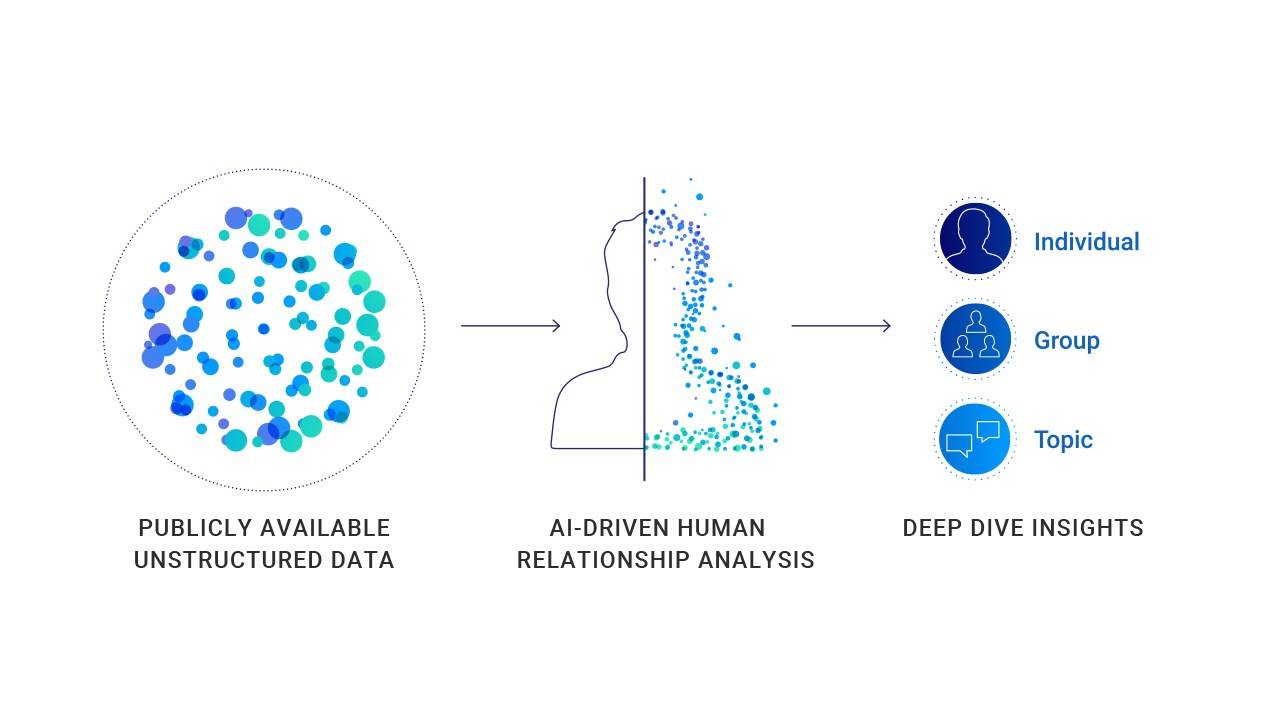

Obtener la información requerida de las redes sociales de todos es el núcleo de este tipo de empresas, que utilizan el contenido publicado por los usuarios en las redes sociales para estimar si es probable que la otra parte cometa un delito. Los algoritmos de estas empresas no son los mismos, pero básicamente utilizan inteligencia artificial para descifrar la línea del usuario, a juzgar por el contenido compartido por el usuario, si el sujeto ha cometido un delito, puede cometer un delito o adherirse a una determinada peligrosa. ideología.

▲ Página web oficial de Kaseware

En realidad, esto no es una novedad, después de todo, en 2012, algunas personas convirtieron las redes sociales en el "pulso de la ciudad". Es difícil ver un espacio y un producto que pueda acomodar a tantos usuarios al mismo tiempo y hacer que estén dispuestos a compartir todo sobre ellos mismos.

Las características de las redes sociales crean condiciones para que las personas encuentren metas.Los estudiantes buscan entrevistados en las redes sociales, las agencias de estadística predicen los resultados de las elecciones en las redes sociales y los detectives de IA quieren encontrar criminales en las redes sociales.

Debido a que todo el mundo usa las redes sociales, las redes sociales a menudo pueden reflejar la situación real de una persona. El representante Tyrone Carter del estado de Michigan de Estados Unidos cree que la búsqueda policial de las redes sociales públicas no violó ninguna ley y no violó los derechos de los usuarios, por lo que esta predicción es factible.

En el momento en que haces clic en enviar en la página pública, la publicación ya no es tuya. La gente se mete en problemas por lo que publica, porque las redes sociales son el mayor "autoinformador" que he visto.

▲ Imagen de: Lifehacker

Pero el secreto solo se revelará cuando sea guiado. Voyager Labs, que cooperó con el Departamento de Policía de Los Ángeles, desempeñó el papel de líder en este proceso. Solo la organización sin fines de lucro Brennan Center descubrió a través de información pública proporcionada por el Departamento de Policía de Los Ángeles que el trabajo de Voyager también era sospechoso de discriminación racial y violaciones de la privacidad.

La forma en que trabajan empresas como Voyager no es complicada. Recopila toda la información pública en las redes sociales de una persona, incluidas publicaciones, contactos e incluso emojis de uso común. En algunos casos especiales, utilizará la información pública y la información no pública para realizar referencias cruzadas para análisis e indexación adicionales.

▲ Voyager emitirá juicios basados en temas de participación personal en las redes sociales.

A través del servicio de Voyager, la policía puede ver claramente las relaciones sociales de una persona. Cómo son sus conexiones y cómo interactúan en las plataformas sociales. Además, Voyager puede incluso detectar si hay una conexión indirecta entre dos usuarios (ambos tienen al menos cuatro amigos idénticos).

Parece que solo está mirando lo que hacen los usuarios en las redes sociales, que se utiliza como información complementaria para las encuestas. Pero, de hecho, la Voyager no solo recopila y muestra información, sino que también emite juicios.

▲ Voyager emitirá juicios y predicciones a través de la cadena de relaciones de la red social.

La Voyager mencionó un caso de agresión en un libro blanco presentado al Departamento de Policía de Los Ángeles. El caso demostró específicamente el enfoque de la plataforma: la IA revisará automáticamente el contenido de las publicaciones de las personas en las redes sociales sin intervención humana. Y la clasificación (respectivamente marque al usuario en tres colores azul, naranja y rojo).

En un caso específico, Adam Alsahli, el sospechoso del tiroteo, fue juzgado por el sistema como "un fuerte sentido de orgullo e identificación con las tradiciones árabes" debido a sus fotos de temática islámica publicadas en Facebook e Instagram. Por lo tanto, Adam Alsahli fue marcado en naranja por la herramienta de inteligencia artificial de la Voyager antes de lanzar un ataque específico.

Este puede ser un caso de predecir con éxito los posibles infractores, pero también un caso lleno de "prejuicios".

▲ La información de las redes sociales de Adam Alsahli, el sospechoso del tiroteo, estaba marcada en naranja antes de que cometiera el crimen.

¿Los datos predicen el crimen? Pero los datos no se pueden creer completamente

¿Son estas conclusiones realmente creíbles? ¿Sobre qué base emiten juicios? ¿Cómo pueden todos demostrar su inocencia con big data?

De hecho, hay muchos datos que confirman la correlación entre el sesgo de contenido de las redes sociales y los hechos delictivos, pero este no es un dato de correlación del 100%.

La Escuela de Ingeniería Tandon de la Universidad de Nueva York y la Escuela de Salud Global y Salud Pública publicaron resultados de investigación que muestran que las ciudades con más discurso de odio racial en Twitter tienen tasas de criminalidad más altas; los estudios en Finlandia también muestran que, según dos décadas de datos, para cada aumento de 1 ° C en la temperatura, la actividad delictiva aumentará en un 1,7%; los estudios estadounidenses han demostrado que la tasa de robo de vehículos en las noches de fin de semana aumenta drásticamente; y se ha demostrado que cuando el equipo de fútbol local pierde accidentalmente, los incidentes de violencia doméstica aumentar en un 10%.

▲ La IA no puede tomar decisiones con un 100% de precisión

Pero estos no pueden probar nada, porque la probabilidad y los hechos son diferentes.

Incluso con el respaldo de datos relevantes, no puede probar que en las ciudades con mayor discurso de odio racial, los vehículos deben ser robados los fines de semana de verano. En climas cálidos, cuando el equipo local local pierde el 100%, ocurrirán más casos de violencia doméstica.

Los sistemas de predicción de delitos similares se invierten en función de los hechos delictivos existentes y los resultados de la investigación. Otro problema que esto crea es que está lleno de "estereotipos".

El ganador del premio Turing, Yang Likun, dijo una vez que cuando los datos están sesgados, los sistemas de aprendizaje automático se vuelven sesgados. En un solo caso, cuando la información recibida por el aprendizaje automático es que los usuarios masculinos negros en prisión representan una gran proporción, dicho sistema puede juzgar que los hombres negros tienen más probabilidades de cometer delitos.

▲ Yang Likun dijo que el sesgo de los sistemas de aprendizaje automático proviene de las personas

Para el aprendizaje automático, "los hombres negros tienen más probabilidades de cometer delitos" puede ser un hecho del análisis de datos, pero en realidad será un prejuicio racial y un trato diferencial.

Calificar secretamente a los usuarios, dividir cuáles son más amenazantes y rastrear y prevenir a aquellos que están amenazados más de cerca son la lógica operativa de todo el sistema.

Startups similares utilizarán algoritmos e inteligencia artificial para explicar el proceso que procesan y analizarán la información para tomar decisiones. Aunque actualmente no hay evidencia que demuestre que esta predicción sea efectiva, y hay muchas dudas por parte del público, el departamento de policía aún quiere cooperar con plataformas similares.

▲ Para la policía, el servicio de pronóstico de la plataforma es muy valioso

Para la policía, este tipo de herramienta es muy atractiva: el descubrimiento de plataformas como Voyager en las redes sociales puede brindar una asistencia eficaz en la elaboración de perfiles de usuarios sin perderse las sutiles pistas en línea. Si es solo una investigación auxiliar, esta será una herramienta muy efectiva. Sin embargo, cuando la herramienta se desarrolle a una etapa posterior y comience a desempeñar un papel en la predicción del crimen, también se convertirá en un arma para herir.

Después del entusiasmo de los años anteriores de financiación, muchos productos de IA han entrado en la etapa de aplicación. Pero en algunas áreas, todavía juegan el papel de auxiliares.

La atención médica es un campo que es cauteloso con la intervención de la IA. Incluso en el campo de imágenes médicas de IA más rápido y avanzado, la tecnología de IA actual todavía no puede garantizar el 100% de precisión y requiere la intervención de médicos humanos. Porque todo el mundo sabe que la atención médica es una industria que requiere casi el 100% de precisión, cualquier desviación o error puede tener graves consecuencias.

▲ En esta etapa, es posible que necesitemos más policías humanos

El campo policial también es un campo que se esfuerza por ser 100% correcto, y cualquier conjetura e inferencia también puede causar graves consecuencias sin el apoyo de pruebas. Una persona que publica varios comentarios discriminatorios y violentos en las redes sociales puede ser marcada como un posible perpetrador. Existe un 90% de posibilidades de cometer un crimen violento, pero antes de que realmente cometa un crimen, es una persona común.

En el conjunto de datos general, nunca podemos ignorar que todos son individuos independientes.

#Bienvenido a seguir la cuenta oficial de WeChat de Aifaner: Aifaner (ID de WeChat: ifanr), se le proporcionará más contenido emocionante lo antes posible.